而在2026年的CES上,英伟达直接自己做了一套面向KV Cache的存储层。由于英伟达的KV Cache存储层明确采用了SSD,而当前SSD市场正受供应紧张和价格上涨的影响,本就紧俏的市场再次被推向高潮。

老黄的这次发布,使SSD热度进一步升温,也直接带动了闪迪、美光、SK海力士等原厂有颗粒厂商的股价再度飙升。过去一年,SSD和磁盘厂商的股票都涨了三四倍,AI让存储陷入疯狂。

首先来看KV Cache是什么?

在大模型推理过程中,每生成一个新 token,其实都要回看前面所有token的信息。如果这些已经算过的中间结果能存下来,下次直接用,就不用从头再算,存储中间结果的数据就是KV Cache。

如果没有KV Cache,就需要很多额外算力。上下文越长,计算量就越大,推理速度会明显变慢,GPU的算力和能耗也会迅速上升。在长对话、长文档或智能体场景下,这种重复计算几乎无法接受。

有了KV Cache之后,在生成新token时,只需要计算当前token的部分结果。如此一来,计算量大幅降低,推理速度更快,GPU更省电,也为长上下文和多轮对话打下了基础。

智能体时代,KV Cache成了新瓶颈

在ChatGPT早期,AI交互主要以单轮问答为主,上下文窗口较短。然而,随着DeepSeek-R1等深度推理模型以及智能体的出现,经常要多步推理、长周期会话,模型需要记住之前发生的事情才能保持逻辑连贯性。

为了保持逻辑的连贯性,就需要模型有较长时间的记忆,这种记忆在计算层面表现为上下文(Context),上下文越多,KV Cache的容量就越大,为了高效地调用KV Cache,就需要存储的支持了。

在英伟达看来,现有的存储层级中,KV Cache数据最理想的情况是放在GPU的HBM里,HBM放不下就存在网络存储中,但这些都没有面向KV Cache场景做优化,成本、效率都有问题。

现有的架构可以分为四层:

G1层是GPU HBM,用于存储热度和延迟要求极高的KV Cache数据;

G2层是系统DRAM,用来暂时存放HBM放不下的KV Cache数据;

G3层是指本地SSD,用于存放在较短时间内会重复使用的KVCache数据;

G4层是指共享存储,用于存储冷数据、历史记录和结果,用来持久保存数据。

G1层主打有更高的性能(纳秒级),而G3和G4主打持久性。随着上下文的增大,KV Cache会迅速耗尽G1,G2和G3层,需要把数据放到G4层(毫秒级延迟),这会带来额外的性能开销,成本和能耗也都会显著增加。

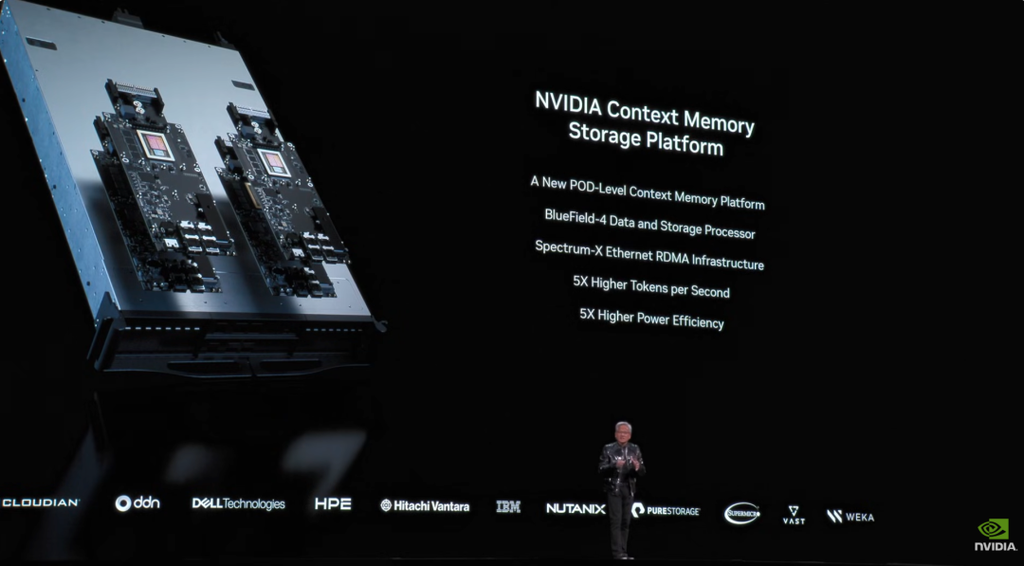

ICMS:英伟达给KV Cache单独加了一个存储层

在英伟达最新的Rubin平台中,英伟达用一个叫Inference Context Memory Storage (以下简称ICMS)的存储平台提供了AI原生存储服务,英伟达的ICMS在G3和G4层之间,被称作是G3.5层。

这个叫ICMS的G3.5层是一个基于以太网的闪存存储层,专门用来存KV cache。它容量足够大,可以作为多个智能体共享的长期记忆。同时又离GPU足够近,能在不影响生成速度的情况下,把上下文的KV Cache频繁预加载回GPU内存。

具体来看,它用了新一代DPU——BlueField-4打造了新的闪存存储层,对推理上下文中的部分KV Cache进行预加载。同时,利用了英伟达Spectrum-X以太网提供的RDMA连接,高效稳定地访问KV Cache缓存。

Pod级共享,让KV Cache真正“复用起来”

ICMS是一个pod级别的共享存储方案,能同时给多个智能体使用,这样就不用在每个节点上单独构建一套方案了。其容量能达PB级别,同时提供很大的聚合带宽,很好地填补了G1、G2、G3与G4之间在性能和容量上的隔阂。

英伟达会用Dynamo这样的推理框架和推理传输库 (NIXL) 提前把即将用到的KV cache从ICMS中预加载到靠近GPU的内存里,配合高带宽网络和BlueField-4 DPU,减少GPU等数据的时间,从而让长上下文和智能体推理的吞吐量最高提升到5倍。

上图中最上层是推理层,NVIDIA Dynamo是一个开源的、低延迟的分布式推理服务框架,Dynamo原本就能把KV Cache从HBM卸载到CPU内存、本地SSD或远程网络存储,只是这次新加入了对ICMS的支持。

在此之下,还有一层具备拓扑感知能力的K8s编排层。使用NVIDIA Grove在不同机架之间调度工作负载,使工作负载即使在节点之间迁移,也能继续复用已有的上下文。

在计算节点层面,KV Cache分散在HBM、主机内存、本地SSD、ICMS以及网络存储中,层级之间通过Spectrum-X以太网连接,把Rubin计算节点与BlueField-4 ICMS连接起来,提供稳定的低时延访问。

BlueField-4和DOCA的作用

BlueField-4 DPU对于ICMS很重要,它提供800 Gb/s的连接速度,它有一个64核的NVIDIA Grace CPU和LPDDR内存。其专用硬件加速引擎可提供高达800 Gb/s的线速加密和CRC数据保护。

BlueField-4 DPU主打的就是对于CPU功能的卸载,这里在做加密的时候也不会增加CPU开销。同时,BlueField-4还支持标准的NVMe和NVMe-oF传输协议,使得ICMS能与现有的SSD和存储系统完美兼容。

DOCA是BlueField DPU的软件开发平台,DOCA Storage是DOCA里的存储模块,现在它引入了一个KV通信和存储层,它可以帮助DOCA与推理框架更好的对接,让BlueField-4高效地处理KV Cache数据。

值得欣喜的是,老黄现在还没做SSD,并且DOCA框架也支持开放接口,可实现更广泛的编排,使存储合作伙伴,特别是SSD厂商能够灵活对接,这也是最近很多SSD厂商股票暴涨的一个重要原因。

英伟达通过开放架构,与顶级存储系统厂商合作,包括VAST Data、IBM Storage Scale、DDN、戴尔、HPE、NetApp、Pure Storage和Weka等都宣布了基于BlueField-4 的ICMSP 产品,形成了庞大的生态支持 。

总结

简而言之,基于BlueField-4的ICMS通过在pod级别引入共享上下文层,把KV cache变成可复用的长期记忆,减少重复计算和推理停顿,在提升吞吐和降低尾延迟的同时,显著改善AI基础设施的总体拥有成本。

德勤预测,到2026年,推理将占所有人工智能计算能力的2/3。推理需求会越来越多,推理上的相关投入也会越来越多,英伟达收购Groq正是看到了这点,而在Rubin平台上推出的ICMS显然也另外一个重要举措。