生成式AI兴起之前的AI只是获得了“看到”和“听到”世界的感知能力,而生成式AI则是让AI获得了会“思考”和“创作”的大脑。现在,智能体让AI获得了自主完成任务的能力,也成了2025年最受关注的AI技术热点。

最近,在世界顶级计算机图形学年度会议SIGGRAPH 2025上,英伟达除了介绍新的基于Blackwell架构的显卡以及服务器硬件以外,还推出了NVIDIA Nemotron家族的新模型,用高级推理能力帮AI智能体做出更明智的决策,处理更复杂的任务。

专门面向AI智能体的NVIDIA Nemotron模型家族

与主要存在于对话框里的生成式AI不同,智能体让AI具备执行复杂任务的能力。事实上,因为AI模型在很大程度上决定了智能体的能力上限,所以市场总是欢迎更强的AI模型,于是英伟达发布了Nemotron Nano 2和Llama Nemotron Super 1.5。

NVIDIA Nemotron模型家族是专门为企业级AI智能体准备的模型,包含一系列多模态推理模型,这些模型在研究生水平的科学推理、高等数学、编程、指令执行、工具调用和视觉推理方面表现都很出色。

与一些有点“来历不明”的模型不同,英伟达Nemotron模型采用透明、开源的训练数据进行训练,为企业提供全面的可见性,有更好的合规性,支持企业商用,总之更适合企业级用户使用,可以避免一些不必要的麻烦。

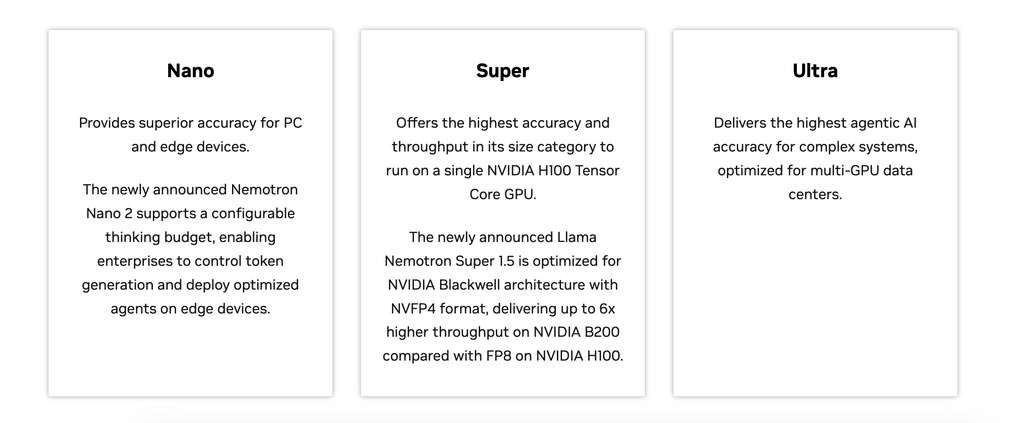

Nemotron模型家族可以分为三大类,可以部署在不同规格的计算平台上:Nano版适合部署在PC和边缘设备上,Super版适合部署在单张GPU上,最强的Ultra版本则需要部署在数据中心里,需要很强的算力和很高的计算精度。

全新的NVIDIA Nemotron Nano 2,推理成本骤降60%

新发布的NVIDIA Nemotron Nano 2不仅实现了同尺寸模型下的最高准确率,并且还加入了可配置的“思考预算”功能,支持用户控制输出的Token的数量,让AI智能体在更深入的思考和更快的执行效率之间寻找平衡点。

据了解,Nemotron Nano 2在相同时间内生成的Token数量提升了最高6倍,同时,相比同类其他开源模型,推理成本降低了60%。智能体每次工作需要耗费的Token很多,成本降低的现实意义很大。

新发布的NVIDIA Llama Nemotron Super 1.5,吞吐量提升6倍

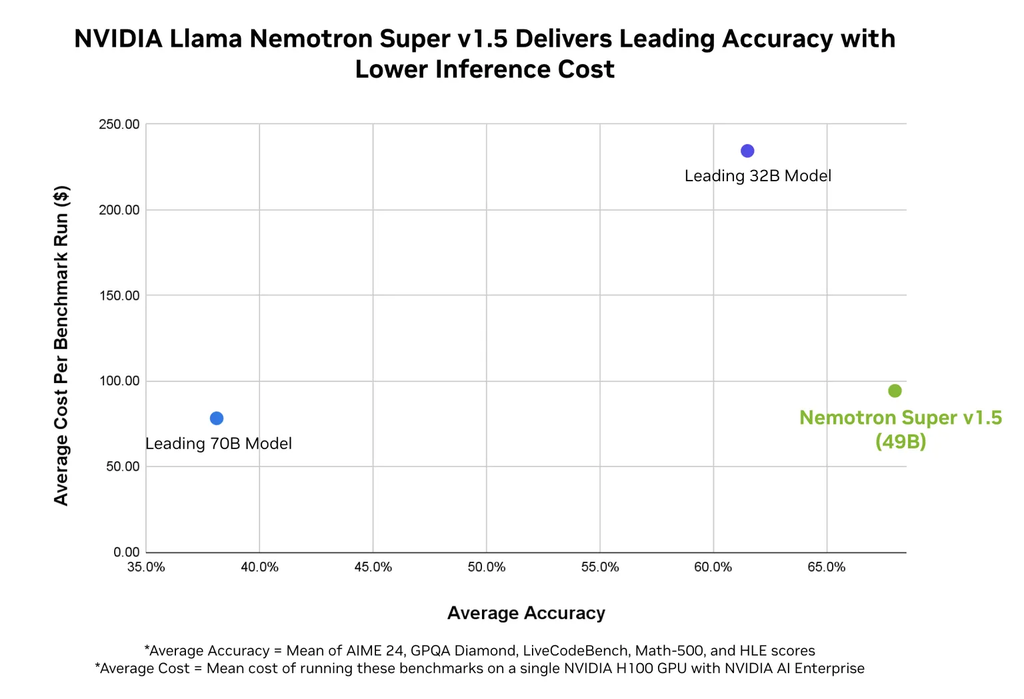

新发布的NVIDIA Llama Nemotron Super 1.5其吞吐量有较大提升。它支持NVFP4格式,NVFP4是英伟达给Blackwell量身打造的格式,在保持模型准确度的前提下提升推理性能和效率,跟Hopper上采用的FP8相比,实现了6倍的吞吐量提升。

Llama Nemotron Super 1.5在同类产品中实现了更高的推理准确性,而且,成本还比较低。与某70B参数的模型相比,它的推理准确性高出很多,而与某32B模型在同一准确度的情况下,成本低了很多。

英伟达Omniverse与仿真技术副总裁Rev Lebaredian介绍称,目前已经有许多软件巨头都在使用英伟达的Nemotron模型,他认为,每个行业里,每个软件平台都会有自己的AI智能体。

比如:安全大厂Crowdstrike利用Nemotron模型,将其安全警报分类的准确率提升了11%;存储大厂NetApp正在其AI数据平台上集成Nemotron,以支持AI智能体进行复杂的商业数据搜索与分析;视频会议巨头Zoom也计划采用Nemotron来帮助用户处理多步骤的复杂任务。

作为开源的模型,NVIDIA Nemotron Nano 2 和 Llama Nemotron Super 1.5 (NVFP4) 将在不久后开放下载。这次,英伟达不仅开放模型,还推出了训练数据集——Llama Nemotron VLM 数据集 v1,开发者可以在Hugging Face上自行下载。