英伟达在AI硬件上的存在感太逆天,以致于明明在开源AI模型领域做了很多,却没有得到相应的关注。最近,英伟达发布Nemotron 3系列开源模型,这不仅是对AI开源社区的又一次重磅贡献,更是任何真正关注AI技术的人不能忽略的好消息。

因为,这次开源不同于以往常见的“伪开源”——只开放预训练后的权重参数,而是开放训练模型的所需的一切,包括训练所需的数据集,所需要的框架类库,还有训练模型的各种技术要点和配方。

可以说,除了没有免费开放硬件计算资源,没有提供免费的技术支持,英伟达把一个企业训练大语言模型所需的所有资源都开放出去了,看来是生怕大家走弯路,称得上是最彻底的开源大语言模型之一了吧。

除了行业领先的开放性,Nemotron 3在架构上的新突破值得瞩目,Nemotron 3 Nano在推理速度和智能水平上也属于行业领先水平。这次开源无疑会加快连锁反应,推动行业衍生出更多优秀模型,在更多行业领域得到应用。

“毫无保留”的开放性,英伟达是真怕开发者走弯路啊

与常规的开源大模型不同的是,Nemotron 3系列除了开放权重参数,还开放了3万亿Token的预训练数据。英伟达企业生成式AI软件副总裁Kari Briski表示,这是本着质量优于数量的原则精心准备的数据,它可以显著提升模型的准确性。

同时,英伟达还开放了1800万的后训练数据样本。这是一个非常庞大的数据集,比目前市面上任何可用的后训练数据集都要大几个数量级,而且,开发者可以更开放地使用这些数据,更清楚地了解模型是基于什么数据构建的。

很多企业不敢用某些模型,是因为担心模型的训练数据有问题。而Nemotron 3开放底层数据集之后,企业不仅能放心地用Nemotron 3,而且能数据放心大胆地调整或者重新训练模型,结合上自己的数据,还能让模型更好地应用于某一特定领域。

光有数据还不够,英伟达还开源了生产级训练框架,这是英伟达内部用于在数千个GPU上训练Nemotron的同款框架,确保开发者获得的是经过实战检验的生产级工具,而非简单的演示代码,这对于训练场景有非常有参考价值。

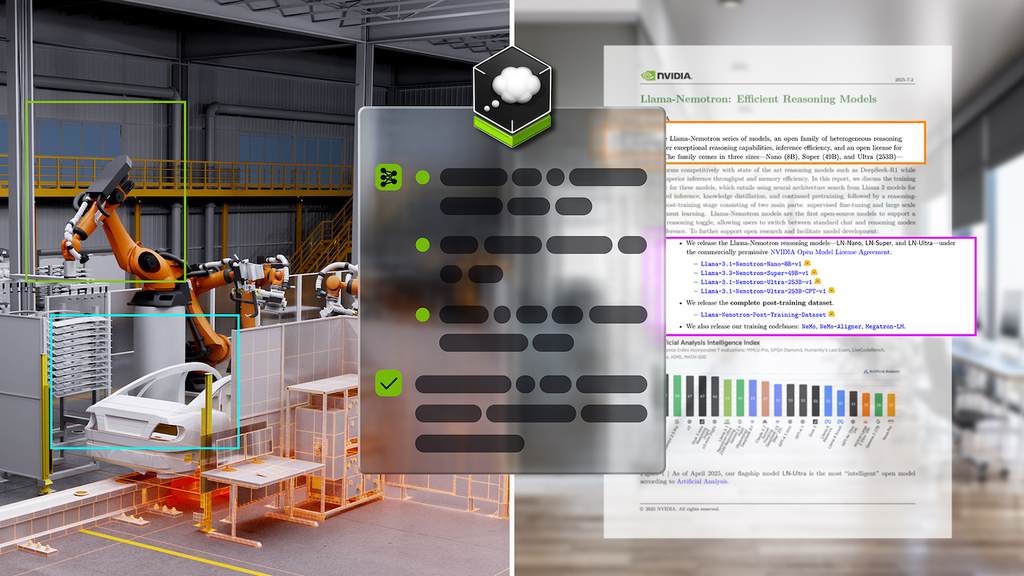

在Nemotron 3 Nano的训练过程中,英伟达引入了多环境强化学习训练,使智能指数提高了约40%。英伟达没有藏着掖着,把强化学习开发环境——Nemo Gym也开放了,这次一口气发布了10个具体的环境,供模型在其中学习和进步。

到此为止了吗?并没有,Kari Briski表示,英伟达还开放了200多个的研究成果,后续还会开放更多技术报告,详细介绍是要如何一步步的构建Nemotron 3。相当于英伟达亲自把模型配方交给你,真的是生怕开发者多走一步弯路啊。

从上图可见,Nemotron 3不仅把模型的开放性拉到了业内的领先水平,同时,其智力水平在同规模的推理模型当中也属于领先水平。这种毫无保留的开放度,或许只有英伟达可以做到吧。

从Kari Briski的介绍中应该意识到,这并非英伟达临时起意,而是既有路线图中的一个阶段。换句话说,Nemotron模型的更新不会烂尾,还有后续,学习和借鉴Nemotron等于是找到一条稳定、有前景的AI模型技术路线,少摸一些石头就能淌过河。

Nemotron 3面向智能体场景,模型架构上有大突破

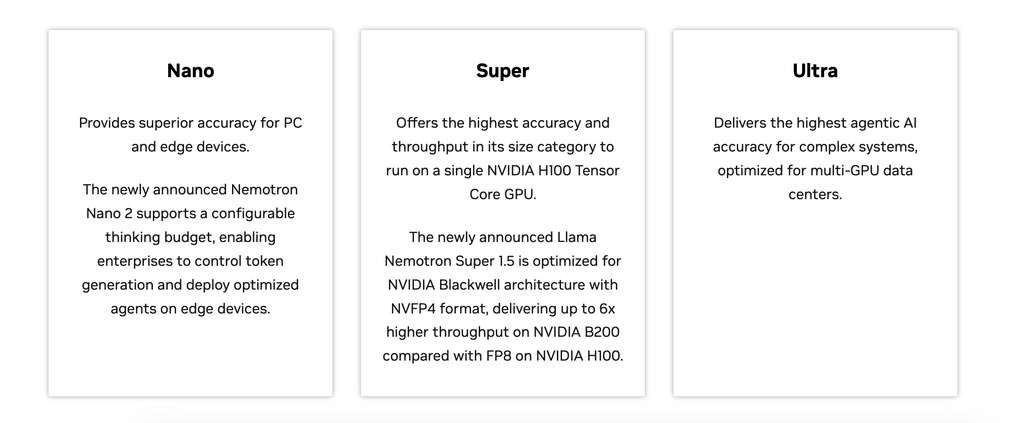

这次新发布的Nemotron 3系列开放模型包含Nano、Super和Ultra三个版本,参数分别为300亿、1000亿和5000亿,三个模型主打代理式AI应用场景,也就是常说的智能体(以下都称智能体)场景。目前只发布了Nano版,后续还会有Super和Ultra版。

三个模型当中,Nano所需的资源最少,可以处理轻量级的智能体工作任务,比如,软件调试、内容摘要、AI助手工作流及信息检索等场景;Super版本则适合多智能体协作的场景;最大的Ultra则适合作为大型推理引擎,它提供了最高的准确性,主要用于构建用于真正复杂的AI应用程序。

得益于异构混合专家 (Hybrid Mixture-of-Experts) 架构的突破,Nemotron 3 Nano的吞吐量比Nemotron 2 Nano高4倍。同时,它还具备100万token的上下文处理能力,具有更强的记忆能力,更擅长处理长时间多步骤任务,更适合智能体场景。

为什么这么强?这里不得不提到这个所谓的异构混合专家 (Hybrid Mixture-of-Experts) 架构,它在前代混合了Transformer架构和Mamba架构的基础上,新加入了MoE架构层,进一步环节了参数规模与推理成本之间的矛盾。

上图展示了Nemotron 3 Nano混合架构的混合方式

传统Transformer架构需要保留所有历史Token的KV Cache,在处理长序列时,会占用非常多的显存资源。而Mamba架构在长序列处理上效率极高,占用的显存会比较少,缺点是从长文中精准提取某个特定事实的准确度不如Transformer。

在Nemotron 3 Nano中,Mamba层负责构建全局上下文,而Transformer层则在关键时刻唤醒,对关键信息进行更细致的注意力计算。这种设计既保留了推理速度,又维持了Transformer级别的逻辑推理能力和准确率,达到了既要又要的效果。

在Mamba架构的支持下,Nemotron 3 Nano可以保持更长的上下文。这使得模型可以一次性输入整本书或者其他丰富的内容数据,话句话说,用户可以直接把这些数据用一个提示词全输入进对话框,而且,Transformer也能保证模型不遗漏掉信息。

同时,为了在不增加推理成本的前提下提升模型的智力容量(参数规模相关),Nemotron 3也使用了MoE架构。以Nemotron 3 Nano为例,虽然拥有大概300亿参数,但在每次只激活约36亿参数,相当于推理的是一个3.6B的小模型,以此来节省资源。

总之,异构混合专家 (Hybrid Mixture-of-Experts) 架构的突破,特别是对显存资源利用率和计算效率的优化,使得Nemotron 3 Nano的吞吐量得到了很大的提升,同时,又能保持很高的智能水平。

此外,对于Super和Ultra版本,英伟达还将额外采用一个叫Latent MoE的架构。英伟达企业生成式AI软件副总裁Kari Briski,用一个形象的比喻介绍了Latent MoE架构的基本原理。

传统的MoE像是一群厨师各在各的厨房忙活,而Latent MoE让所有厨师共享一个具备基础能力的中央大厨房(公共核心),同时保留各自的小香料架(私有专家参数)。这种设计可以极大地提高显存使用效率,让大模型的部署门槛显著降低。

据介绍,Super和Ultra模型还会使用英伟达Blackwell架构所支持的NVFP4计算精度,相比BF16或FP8,可显著降低显存需求并加速训练进程。结合模型架构和硬件效率的双重优化,将进一步提高AI的训练和推理效率。

到底谁在用英伟达Nemotron呢?

英伟达在AI开源领域上做了很多。2025年,英伟达是Hugging Face上开源模型、数据和配方(Recipes)的领域顶级贡献者,拥有650个开放模型和多达250个开放数据集。你或许很想知道,到底谁在用Nemotron呢?

在一些多智能体AI系统中,更强的专有模型和开放模型经常搭配使用,以此来平衡性能与成本。在同一工作流中,将复杂推理交由前沿模型,将常规任务分配给Nemotron等开放模型,既保障了智能体的整体能力,也显著优化了token的使用效率。

Perplexity CEO Aravind Srinivas 表示,其智能体路由机制可根据任务特性灵活调用Nemotron 3 Ultra 等精细调优的开放模型,或在需要时引入领先的专有模型,从而让AI助手在速度、效率和规模上有更好表现。

Nemotron 3正在帮助初创公司加快AI智能体的开发与迭代,缩短从原型验证到企业级部署的周期。包括General Catalyst和Mayfield在内的多家投资机构,其投资组合公司已开始探索基于Nemotron 3 构建支持人机协作的 AI“队友”。

Mayfield管理合伙人Navin Chaddha表示,英伟达的开放模型与初创加速计划为创业团队提供了丰富的模型、工具和基础设施,使其能够快速发展。借助Nemotron 3,初创公司在智能体AI和AI队友等新应用方向上有望更快取得优势。

Nemotron模型已被集成到制造、网络安全、软件开发、媒体、通信等行业的AI工作流中。Nemotron系列模型的早期用户包括埃森哲、Cadence、CrowdStrike、Cursor、德勤、安永、甲骨文云、Perplexity、ServiceNow、西门子、新思科技和Zoom。