不是我说的。号称是HBM之父的韩国科学技术院(KAIST)Jung-Ho Kim教授发布视频称,英伟达未来可能要收购美光或闪迪等主流内存企业。

分析一下。如果真,那么英伟达将减少对三星/SK海力士的HBM依赖,掌控内存核心技术(如HBF)。然后能垂直整合降低供应链风险,长期压缩AI芯片成本。简而言之,英伟达更有钱了。

对被收购方而言,美光或闪迪的股东将直接获得估值溢价收益,同时成为英伟达核心供应商。

不过,问题也很多,比如收购美光可能要通过多国监管机构同意,耗时长,变数多。英伟达+美光这样的巨无霸还可能会触及垄断审查。而闪迪是西数闪存业务核心,收购闪迪要经过西部数据同意。

这位教授还用蛋糕与奶油打比喻,形容GPU与内存的关系,GPU像蛋糕胚,内存是提升AI性能的奶油层。生成式AI响应速度的关键在于内存性能,尤其在推理阶段比训练阶段更为重要。

随着AI模型参数量、用户规模及数据类型(文本→图像→视频)的指数级增长,内存容量需求已逼近临界点。

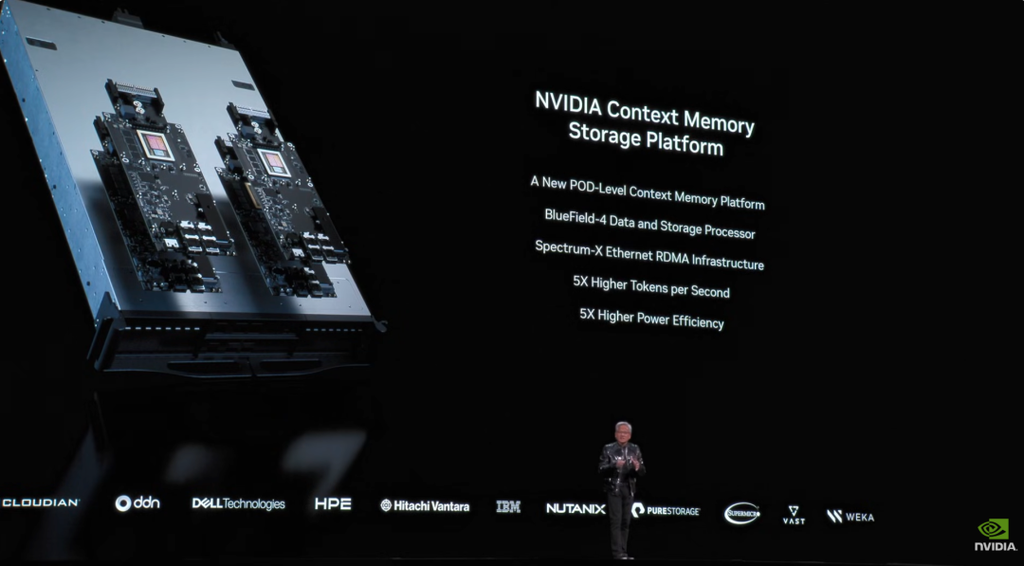

未来AI计算的内存分级架构会是:

SRAM(GPU内置):速度最快,容量最小;

HBM(GPU旁的书架):用于编解码计算,支持高速读写

HBF(地下室图书馆):推理专用,动态补充HBM数据

网络存储(公共图书馆):通过光网络连接的海量存储

未来,AI内存需求每两年翻倍,20年后市场规模有望从千亿美元级跃升至万亿美元级。在GPU性能受制于摩尔定律放缓的背景下,内存技术创新正成为AI计算的新引擎。Kim教授称内存时代已至,掌握HBM/HBF核心技术的企业将主导下一轮资本市场浪潮。