刚刚,美团正式发布 LongCat-Flash-Chat,并同步开源。LongCat-Flash 采用创新性混合专家模型(Mixture-of-Experts, MoE)架构,总参数560B,激活参数 18.6B~31.3B(平均 27B)。

我现在想做的就是去https://longcat.ai/,和龙猫对话:

第一步注册:页面很干净,登陆按钮在左下方,很隐秘。然后我从美团APP扫码注册了这个大模型。

这感受非常新奇,像日常打了个订餐电话,它回复你:颤抖吧,客户朋友,我能给你写文案做数据分析了。订餐员变技工既视感,看到有个群友说:美团首先是一家科技公司。

突然想起七八年前的的美团云,参加过一次活动,当时它有自家的外卖业务上云托底,是实在案例,向外发展迅速,还换了个新品牌logo,代表无穷的动态符号,之后几年人员动荡战略调整各种原因吧就关闭了对外的公有云服务。

不记得当时什么想法,时至今日,我依然保留着这个动态logo

那时的意气风发,如今成了AI时代再次出发的序章。

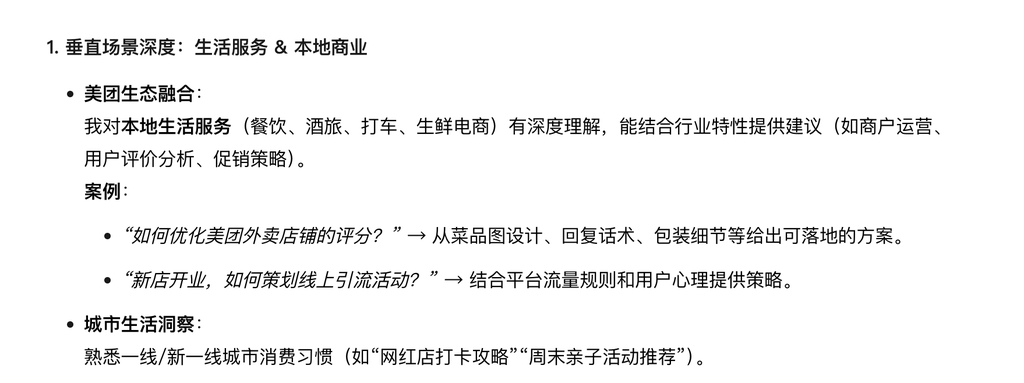

目前看,这是一个网页,不知道以后是在美团APP开模块,还是新开一个龙猫应用。目前无法生成图片和视频。问它有什么长处?

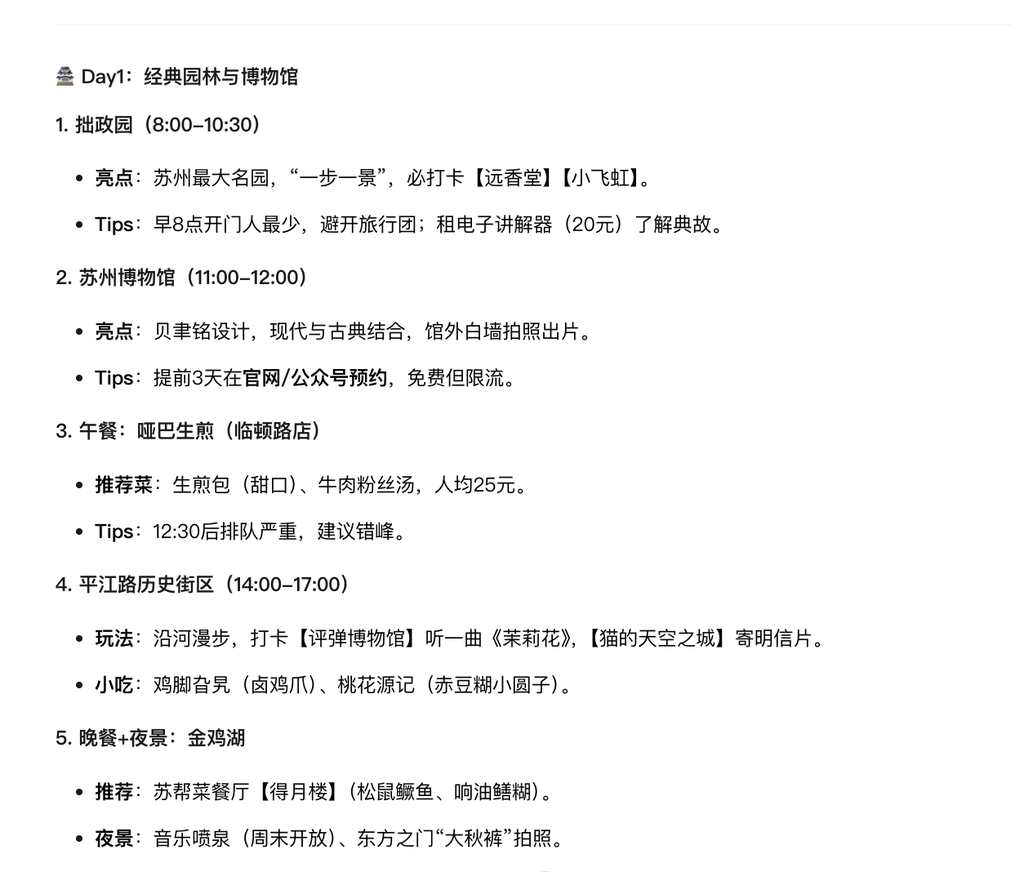

然后说自己本地生活服务很厉害,我的理解就是旅游出行规划6,然后问了苏州旅游规划,还推荐哪家东西好吃,对比一下确实比其他大模型周到,甚至连店铺都照顾到了,而且因为我做过攻略,这份推荐基本可信。

又随机问了最近的热播剧献鱼,想让它用古龙小说风格介绍一下剧情。联网状态也不行,就是它的信息还没更新到最近,起码半个月时间。

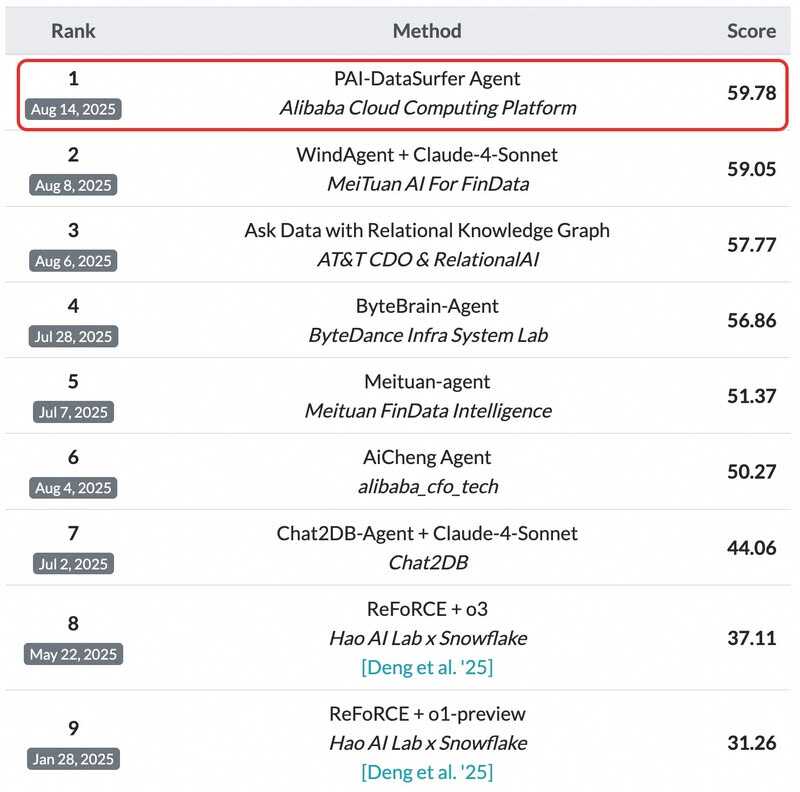

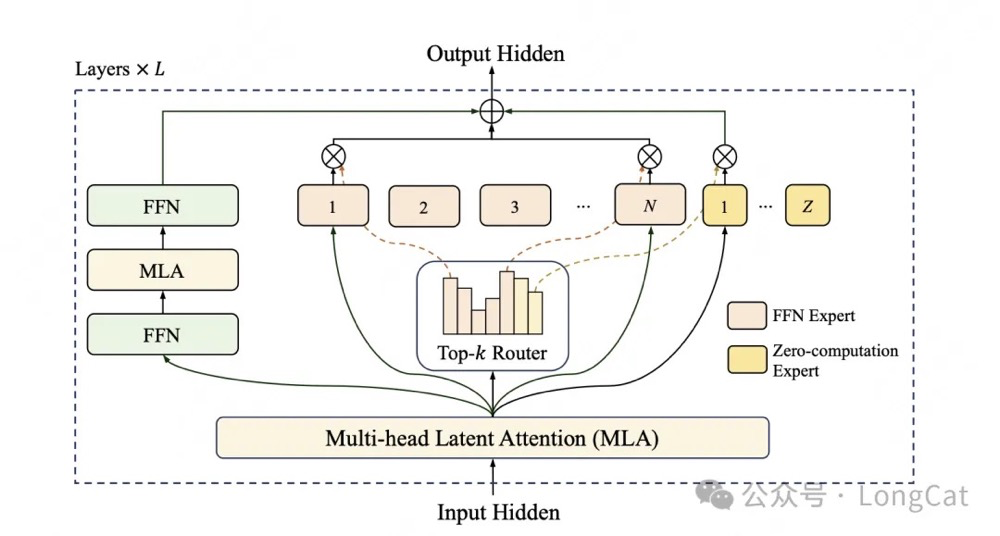

下面是一些美团公布的测试成果,有兴趣可自行查看:

根据多项基准测试综合评估,作为一款非思考型基础模型,LongCat-Flash-Chat 在仅激活少量参数的前提下,性能比肩当下领先的主流模型,尤其在智能体任务中具备突出优势。

因为面向推理效率的设计和创新,LongCat-Flash-Chat 具有明显更快的推理速度,更适合于耗时较长的复杂智能体应用。

目前,美团在 Github、Hugging Face 平台同步开源。

/ 技术亮点 /

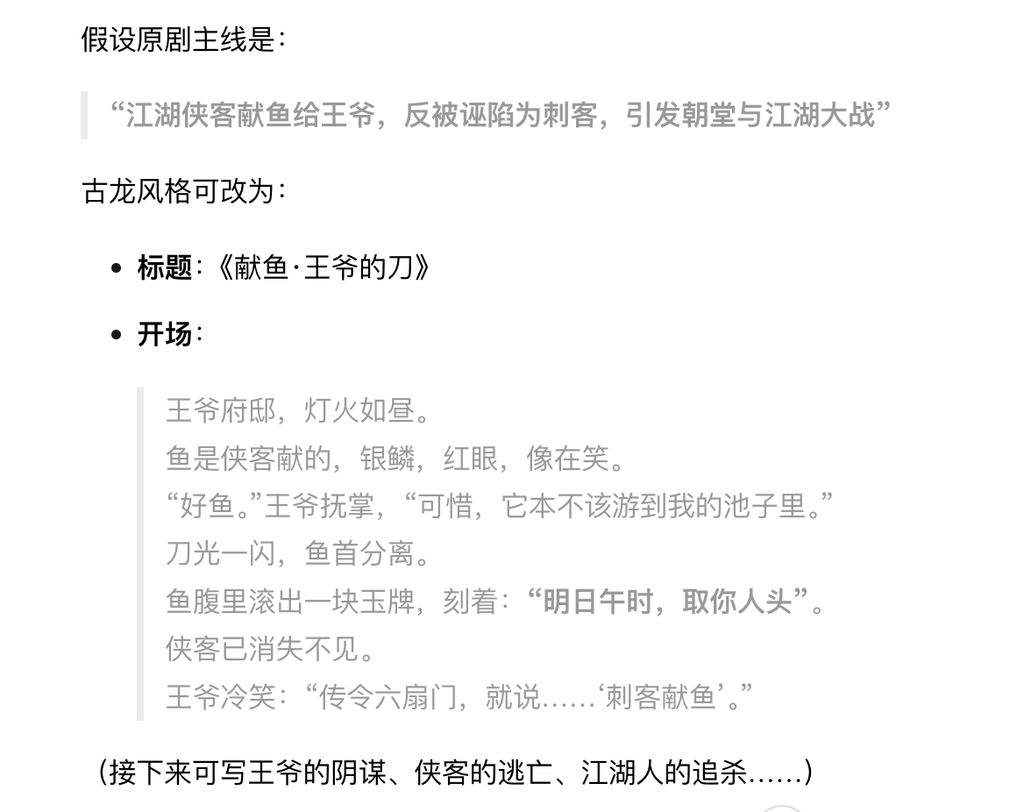

LongCat-Flash 模型在架构层面引入“零计算专家(Zero-Computation Experts)”机制,总参数量 560 B,每个token 依据上下文需求仅激活 18.6B~31.3 B 参数,实现算力按需分配和高效利用。为控制总算力消耗,训练过程采用 PID 控制器实时微调专家偏置,将单 token 平均激活量稳定在约 27 B。

图1:LongCat-Flash 架构图

通过算法和工程层面的联合设计,LongCat-Flash 在理论上的成本和速度都大幅领先行业同等规模、甚至规模更小的模型;通过系统优化,LongCat-Flash 在 H800 上达成了 100 tokens/s 的生成速度,在保持极致生成速度的同时,输出成本低至 5元/百万 token

图2:LongCat-Flash 的基准测试性能