导读

随着MCP从一个技术构想迅速成为行业共识,一个新的生态层级——MCP交易平台——应运而生。

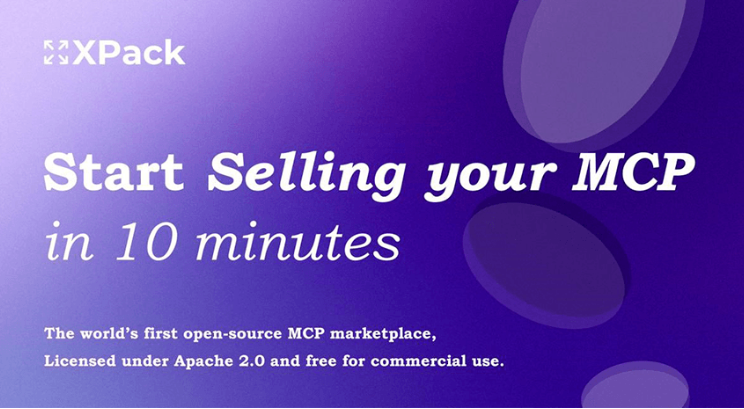

它不仅是协议的实现,更是商业模式的创新。本文将深度聚焦于这一新兴赛道的开创者之一,由深圳银云推出的全球首个开源MCP交易平台XPack.AI。我们将系统性地解构MCP协议的内在价值,剖析XPack.AI如何试图抓住这一历史性的机遇,并从产业战略和底层技术的双重维度,探讨它对未来AI生态格局可能产生的深远影响。

这不仅是一个关于技术协议的故事,更是一个关于新经济范式、平台战略和未来智能社会基础设施构建的宏大叙事。

文字编辑|宋雨涵

1

AI Agent的“最后一公里”困境

MCP作为新大陆的浮现

2025年的今天,人工智能的浪潮正以前所未有的速度重塑着数字世界的边界。如果说大型语言模型(LLM)的出现是为机器注入了“思考”的灵魂,那么AI Agent(智能体)的兴起,则预示着这颗“大脑”即将拥有“手脚”,从一个被动的问答工具,进化为能够自主理解、规划并执行复杂任务的“数字员工”。从自动预订旅行、管理日程,到执行复杂的商业分析、编写代码,AI Agent的宏大愿景正激发着全球科技界最狂热的想象力。

然而,理想的光芒之下,现实的骨感愈发清晰。一个强大的AI Agent,如同一个拥有超级大脑但被囚禁在密室中的天才,其能力被无形的墙壁所禁锢。这堵墙,就是它与广阔、动态、异构的现实世界之间的连接鸿沟。现实世界由无数的API、SaaS服务、实时数据库和专业工具构成,每一个都有其独特的“语言”和“规则”。当前的集成方式,大多停留在点对点的定制化开发阶段——为每一个Agent、每一个外部服务,都需编写特定的“翻译”代码。这种“手工作坊”式的连接,混乱、脆弱且成本高昂,根本无法支撑起一个由数万亿Agent构成的智能生态。

这便是AI Agent落地的“最后一公里”困境——一个关乎规模化、效率和可行性的核心障碍。当整个行业都在为Agent的“智能”欢呼时,连接的“管道”却成为了最脆弱的瓶颈。

MCP的诞生与介绍

正是在这一背景下,一个名为MCP(Model Context Protocol,模型上下文协议)的全新范式浮出水面。它不旨在提升模型本身的智能,而是专注于解决连接问题。MCP被业界生动地比喻为“AI世界的USB-C接口”或“AI的通用语”,其核心价值只有一个词:标准化。它试图为AI Agent与纷繁复杂的外部世界之间,建立一座统一、稳固且高效的桥梁,让任何工具和服务都能被Agent“即插即用”。

MCP,全称Model Context Protocol,即模型上下文协议,最初由领先的AI公司 Anthropic(Claude的创造者) 在2024年推动并开源,其核心目标是标准化AI模型(尤其是LLM和Agent)与外部工具、数据源之间的交互方式。它不仅仅是一个技术接口规范,更是一套完整的“语义沟通框架”。

我们可以用一个生动的比喻来理解MCP的工作原理:

想象一下,AI Agent是一个聪明的总指挥,它需要调动外部的各种“专家”(如天气查询工具、订票系统、数据分析软件)来完成任务。在没有MCP的时代,总指挥需要为每个专家学习一套独特的沟通方式和操作手册,过程极其繁琐。而MCP的出现,相当于为所有专家提供了一套标准化的“工具说明书”(即MCP卡片)和一个“标准插座”(即MCP主机接口)。

行业趋势确立:巨头抢滩,标准之争初现端倪

一项技术标准能否成功,关键在于能否获得行业巨头的支持并形成网络效应。在这一点上,MCP已经展现出强大的势头。继Anthropic之后,Google迅速在其开发者工具和AI平台中集成了对MCP的支持。在中国,科技巨头也闻风而动,例如,百度智能云千帆平台在其4.0版本中,不仅将自家的AI搜索能力封装为MCP服务,还宣布全面拥抱MCP生态,并支持A2A(Agent-to-Agent)协议,旨在构建一个开放协作的Agent网络。

巨头们的纷纷入局,一方面验证了MCP作为未来连接标准的前瞻性和正确性,为其普及铺平了道路;另一方面,也预示着一场围绕标准主导权和生态控制权的暗战已经打响。

2

XPack.AI登场

打响MCP商业化第一枪

如果说MCP协议绘制了AI Agent连接万物的蓝图,那么XPack.AI则试图成为将这张蓝图付诸实践、并构建起商业帝国的第一个“施工队”和“交易市场”。它的出现,标志着MCP从一个纯粹的技术规范,开始向一个充满商业活力的经济生态演进。本部分将深入剖析XPack.AI的诞生背景、产品模式及其背后惊人的商业构想。

从API治理到AI赋能——XPack.AI的“基因”与远见

XPack.AI并非横空出世的产物,其背后是深圳银云信息技术有限公司及其创始人刘昊臻在API领域长达十年的深耕。根据公开资料,深圳银云旗下的核心产品Eolink,早已是国内最大的API全生命周期治理平台之一,服务了超过百万的开发者,管理着数十亿级的API。

XPack.AI是什么?——一个为AI服务的“Shopify”+“App Store”

XPack.AI的官方定位是“全球首个开源MCP交易平台”。为了更形象地理解其商业模式,我们可以将其拆解为两个经典互联网平台的结合体:

对于服务提供商,XPack.AI是“Shopify”: 它提供了一套完整的开店工具,让任何拥有数字服务(API、SaaS功能、数据、甚至网站内容)的个人或企业,都能快速、低成本地开设自己的“MCP商店”。

其核心功能直击痛点:

极速部署与转化: XPack.AI的开源版本宣称“10分钟内就能从0到1部署一个MCP交易平台”,同时提供“一键将已有API转换为MCP”的功能。这几乎将服务提供商进入AI生态的技术门槛降至零。

开启新商业模式: 服务商可以在平台上将自己的服务“卡片化”,并自主定价销售。这意味着,无论是垂直领域的SaaS公司、提供金融或天气等实时数据的机构,还是拥有专业设计、多模态生成等能力的工具型API,都可以将其能力单元化,作为商品直接出售给全球的AI Agent。未来,XPack.AI甚至计划支持“一键将任何网站转换为MCP”,让内容创作者也能参与到这场变革中。

独立品牌与推广: 每个在XPack.AI上建立的站点都是相对独立的,可以绑定自己的域名、品牌和Logo。平台则负责通过SEO、KOL传播等方式为这些站点引流,解决了服务商的获客难题。

对于AI Agent开发者,XPack.AI是“App Store”: 它提供了一个不断增长、品类丰富的全球化“工具/能力市场”。

Agent开发者不再需要四处寻找和适配API,只需接入XPack.AI这个巨大的“应用商店”,就可以让自己的Agent按需、动态地发现、评估和调用成千上万种标准化的MCP服务。这极大地丰富了Agent的能力边界,加速了从“玩具”到“生产力工具”的进化过程。

3

MCP的辐射效应:

算力版图的重构与新机遇

从硬件和基础设施的视角看,MCP生态的繁荣将深刻地改变AI算力的需求分布和形态,催生全新的技术机遇和挑战。

算力需求的再分配 —— 从“中心化大脑”到“分布式工具节点”

当前AI算力的需求高度集中在两个环节:用于训练超大模型的“数据中心级”算力集群,以及用于LLM推理的“云端/边缘”推理服务器。这是一种中心化的算力模式。而MCP生态的崛起,将引入第三个重要的算力需求点:成千上万个提供MCP服务的“工具节点”。

这些工具节点可能是一个提供专业物理模拟的SaaS服务,一个进行实时金融数据分析的API,或是一个执行多模态内容生成的模型。它们各自都需要独立的、专门优化的算力。这意味着,算力需求将从少数几个超大规模的“大脑”(LLM),分散到无数个功能各异的“手脚”(MCP服务)上。这将极大地推动对以下领域的需求:

专用加速芯片(ASIC): 针对特定MCP服务(如视频转码、蛋白质折叠、量化交易分析)的高度优化芯片,将比通用GPU更具能效比。

边缘计算与分布式推理: 许多需要低延迟响应的MCP服务(如实时导航、工业控制)将被部署在更靠近数据源的边缘节点上,这将引爆对边缘AI芯片和分布式推理框架的需求。

对于芯片设计公司而言,这意味着一个新的、更加碎片化但也更广阔的市场。未来的竞争不再仅仅是“谁的通用AI芯片性能更强”,还包括“谁能为最热门的MCP服务类别提供最高效的算力解决方案”。

洞察二:协议效率与硬件成本的直接挂钩

在一个由机器高频交互的生态中,协议本身的效率至关重要。MCP协议的每一次调用,都涉及到网络传输、数据序列化/反序列化、安全验证等开销。当一个复杂任务需要Agent串联或并联调用数十个MCP服务时,这些微小的开销将被急剧放大,直接影响整个系统的响应速度和运行成本。

这将为底层硬件带来新的优化方向:

网络芯片(DPU/IPU): 能够硬件卸载MCP协议解析、安全加密/解密等任务的智能网卡,将极大降低CPU的负担,提升整个节点的处理吞吐量。

内存与存储: 针对大量小数据包、高频读写优化的内存和存储技术,将有助于降低MCP服务调用的延迟。

简而言之,MCP生态的成熟将使得“软件协议”与“硬件性能”之间的关系变得前所未有的紧密。协议的每一个细节,都可能转化为对底层芯片的具体设计要求。对于像XPack.AI这样的平台方,与硬件厂商合作,共同定义和优化协议与硬件的协同,将可能成为其构建长期竞争壁垒的关键。

结语:

AI Agent所承诺的革命性潜力,其能否真正释放,不再仅仅取决于模型本身有多“聪明”,而更多地取决于我们能否为它们构建一个高效、可靠、可扩展的连接层。MCP协议的出现,正是对这一时代需求的精准回应。而XPack.AI的探索,则勇敢地将这一技术构想推向了商业实践的最前沿。