2025年12月4日,亚马逊云科技发布新一代自研Arm处理器Graviton5以及基于基于该处理器的M9g实例,这次发布不同以往,它第一次在一台服务器里实现了Graviton5与Amazon Nitro以及Trainium3芯片的协同,服务器核心芯片全自研!

上图是亚马逊云科技高级副总裁Peter Desantis的分享:

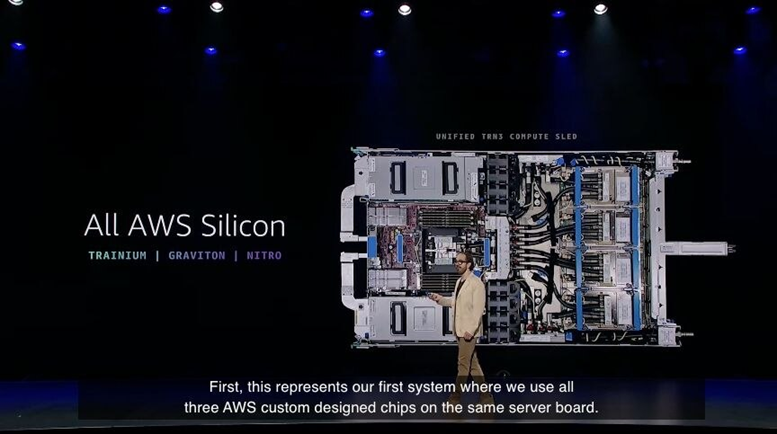

上图中最右侧是四块Trainium3芯片,最左侧被内存条包围在中间的是Gravion5处理器,这五位散热大户的液冷管集中到了中间。而在Gravion上面和下面的则是两套Amazon Nitro系统,整体结构有一种对称美。

在大会现场展区近距离观察可以看到,这大概是1U规格的液冷服务器,服务器里密密麻麻的有各种零件,空间利用率非常高。当这样36台服务器堆在一起,然后通过Neuron Switch把Trainium3连起来之后,就组成了EC2 Trn3 UltraServers实例。(注:NeuronLink是负责连接Trainium芯片的专有协议)

这样一台实例包含144块Trainium3芯片,而上一代Trn2 UltraServers只能它一共64块Trainium2芯片。对比之下,计算性能提升到了4.4倍,FP8算力达到360PFlops,内存带宽提升到了3.9倍,达到700TB/s,内存容量也达到了20TB。(算下来,一块Trainium的HBM大概是138G)

Trn3 UltraServers的密度大大提升。Trn2 UltraServers是由4个EC2 Trn2实例组成的,每个实例中包含8个放着Trainium2芯片的服务器,密度低,可维护性差。而现在,一个Tra3 UltraServer的计算节点就能放置4块Trainium,36个节点提供144块Trainium3,芯片和算力密度大大提升。

带来密度提升的一个关键就来自于自研的Gravion5芯片。Gravion5的性能够强,强到足以替换原来的基于x86架构的专用的头CPU节点,由于I/O性能比较强悍,即使带着4块Trainium,也能让Trainium3芯片足以充分发挥性能,不划水。

在将Gravion5作为这台AI服务器的头结点之后,还提高了系统的可维护性。Peter Desantis介绍说,Graviton 服务器支持用户一次仅对36个节点中的一个进行维护,不需要让别的计算节点也退出生产环境,这种类似热插拔的设计让计算节点持续工作。

此外,由于这台UltraServers服务器完全是由机器人组装的,这可以让服务器快速完成组装和上线。与此同时,当服务器需要维护时,可以由快速完成替换和维护,运维效率非常高。

此外,服务器的两张Nitro 卡可以提供高速的EFA网络,它让Tranium 服务器能够与数千台其他 Tranium 服务器共享内存,通过加密通道直接读写彼此的内存,并具备内置的网络多路径和容错能力。以此来构建大规模训练集群,可以用来训练和推理大型模型。

这次亚马逊云科技发布Trn3 UltraServers,意味着AI计算硬件上可以彻底摆脱对x86架构的依赖,也摆脱了对于英伟达的依赖,这不仅让亚马逊云获得了更大的技术自主权,供应链掌控力,还有实实在在的成本下降,对于未来五年十年有战略意义。

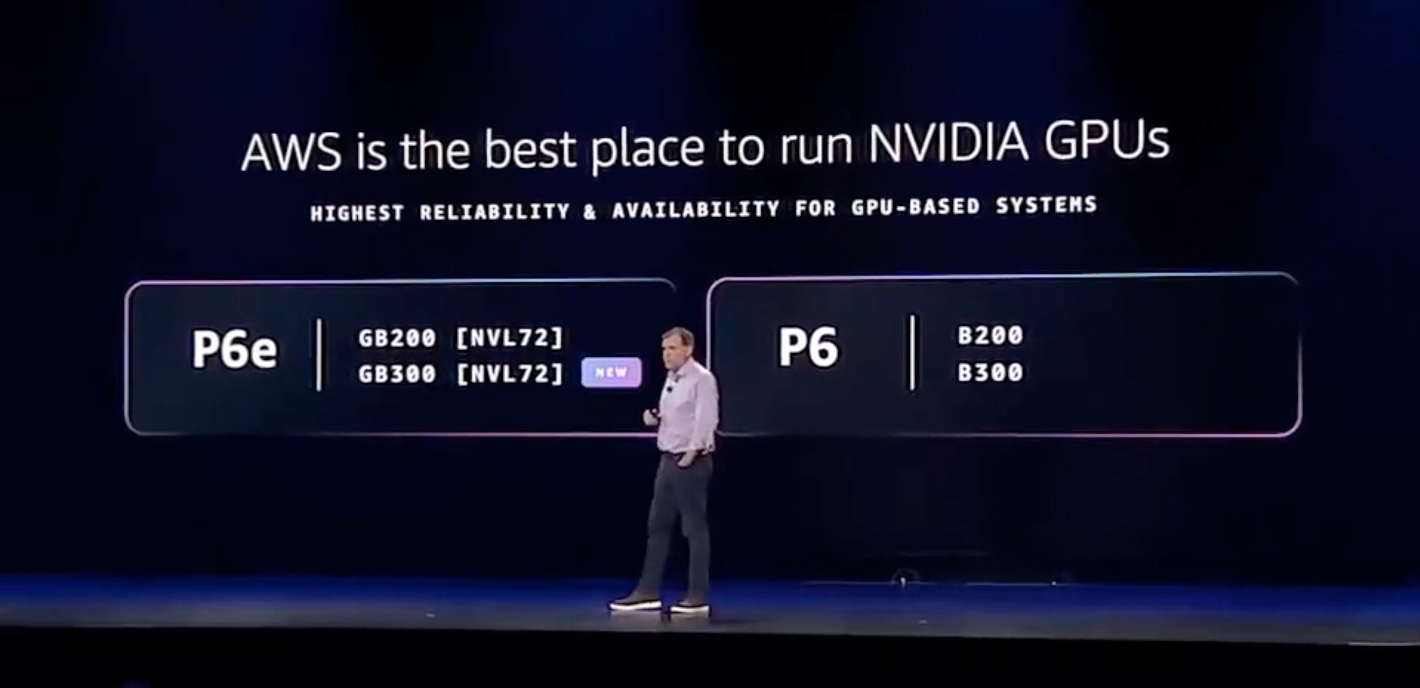

当然,亚马逊云科技并不是要一昧地摆脱依赖,构建封闭的技术生态。亚马逊云向来主打一个开放,CEO Matt的演讲中可以看到,亚马逊是愿意成为最适合英伟达GPU的云平台的,这能让亚马逊服务更多客户,包括OpenAI和英伟达。

从技术规划来看,这几天,亚马逊云宣布将在下一代Trainium4中集成英伟达的NVLink Fusion,让Trainium4进入英伟达的NVLink技术生态,这意味着会在Trainium4植入英伟达的小芯片,利用英伟达的Grace CPU和NVLink交换机技术生态。

期待未来这一方案的落地会带来哪些价值,也期待更多技术方案推动AI技术更好的发展和落地。