5月13日,清华大学自然语言处理实验室(THUNLP)和面壁智能(ModelBest)联合开源了移动端GUI智能体模型——AgentCPM-GUI。项目基于MiniCPM-V模型(80亿参数)构建,旨在提升移动设备上的人机交互体验,尤其是中文应用场景中的表现。

清华大学THUNLP实验室长期致力于自然语言处理和人工智能领域的研究,而面壁智能则专注于大模型技术的创新与应用。双方此前已在多模态模型MiniCPM-V的开发上展开合作,取得了很多成果。此次联合推出的AgentCPM-GUI,是双方在移动端智能体领域的一次重要尝试,标志着大模型技术在移动设备上的进一步落地。

AgentCPM-GUI的核心功能

高质量的GUI理解能力:通过在大规模中英文安卓数据集上进行预训练,模型对常见GUI控件(如按钮、输入框、标签、图标等)具备定位与理解能力,为精确操作打下基础。

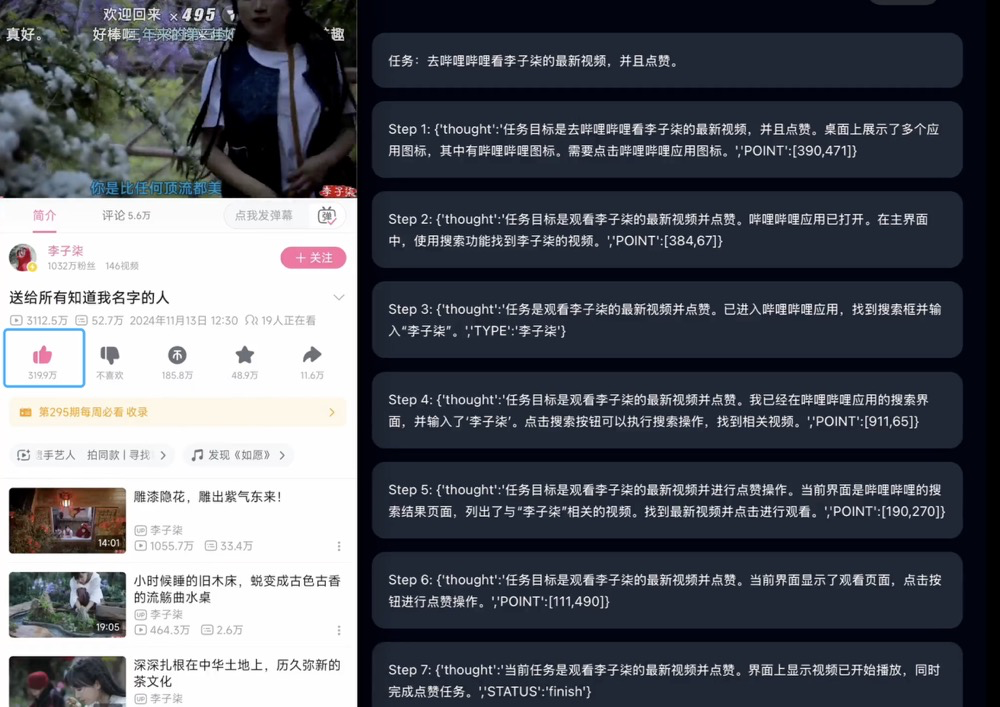

中文应用深度适配:AgentCPM-GUI是首个针对中文应用精细优化的开源GUI智能体,支持高德地图、大众点评、哔哩哔哩、小红书等30余个主流中文应用,解决了中文界面交互的特殊挑战。

增强的规划与推理能力:通过强化微调技术(RFT),模型在输出动作前进行详细的推理思考,显著提升复杂任务执行的成功率,使操作更加智能化。

紧凑的动作空间设计:采用优化的动作空间和紧凑的JSON格式,将平均动作长度压缩至9.7个token,提升了移动端推理效率,降低了资源消耗。

AgentCPM-GUI的训练流程包括两个阶段:

监督微调(SFT):使用包含屏幕截图和相应操作的大规模标注数据集,训练模型理解界面元素并生成正确的操作行为。

强化微调(RFT):通过自我探索和反馈机制,优化模型的思考能力和决策策略,提高复杂场景下的任务完成率。

此外,模型的动作设计采用JSON结构化输出,支持多种操作类型,如点击、滑动、输入文本、按键操作等,增强了模型的可解释性和实用性。

应用场景:

AgentCPM-GUI的应用场景广泛,包括:

智能手机自动化:替代传统脚本,通过自然语言指令完成日常操作任务。

无障碍辅助:帮助行动不便用户操控手机应用。

应用测试与质量保证:自动执行应用测试流程,发现潜在问题。

智能助手集成:为现有智能助手提供视觉交互能力。

教育引导:辅助新用户学习复杂应用的使用方法。

未来,AgentCPM-GUI有望扩展到更多应用场景和平台,如iOS和桌面系统,增强跨应用任务规划和执行能力,降低模型参数量,提升端侧部署效率,并增强个性化适应能力,根据用户习惯调整交互方式。

AgentCPM-GUI已在GitHub开源,可访问:https://github.com/OpenBMB/AgentCPM-GUI