从A100、H100到最新的Blackwell 架构B200“核弹”级超级芯片,NVIDIA GPU总是不断刷新AI性能的极限,以B200为例,单个GPU就可以提供20 petaflops的算力,4倍与原有的AI训练性能和30倍的推理性能。

面对 NVIDIA 每一次激动人心的突破,你是不是也是难以抑制跃跃欲试的冲动,想尽快拥有这样的“核武器”。但是很遗憾, NVIDIA 仅仅提供了AI服务器的参考架构,并不直接生产服务器。要把超级芯片转化为生产力,要需要服务器厂商完成好作业。

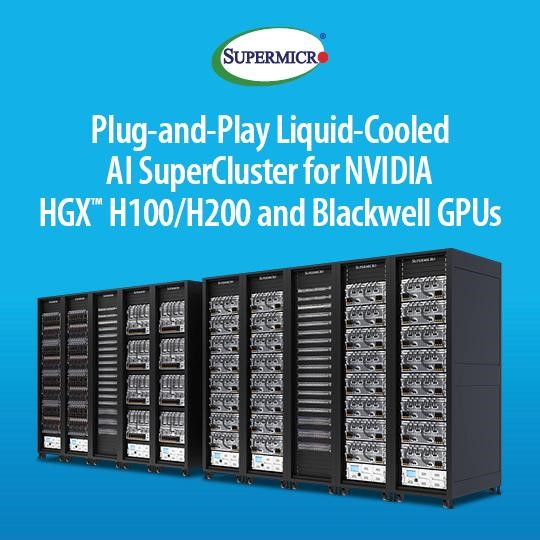

如今,Supermicro的作业完成了,而且很出色。

作为AI、云端、储存和 5G/边缘领域的全方位IT解决方案制造商,Supermicro推出了基于NVIDIA Blackwell架构的完善产品系列,支持新型NVIDIA HGXTM B100、B200和GB200 Grace Blackwell Superchip。在Supermicro的支持下,各大数据中心很很容易就实现AI大模型的即插即用,不仅如此,液冷型产品设计也有助于降低AI的运营成本。

Supermicro目前的生成式AI SuperCluster产品包括:

● 液冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256个H100/H200 GPU,为5个机柜规模的可扩展计算单元(包括 1 个专用网络机柜)

● 气冷型Supermicro NVIDIA HGX H100/H200 SuperCluster,具有256个HGX H100/H200 GPU,为9个机柜规模的可扩展计算单元(包括1个专用网络机柜)

● Supermicro NVIDIA MGX GH200 SuperCluster,具有256个GH200 GraceTM Hopper Superchip,为9个机柜规模的可扩展计算单元(包括1个专用网络机柜)

Supermicro SuperCluster支持NVIDIA AI Enterprise,其中包括NVIDIA NIM微服务和NVIDIA NeMo平台,能实现端对端生成式AI客制,并针对NVIDIA Quantum-2 InfiniBand以及具有每GPU 400Gb/s网速的新型NVIDIA Spectrum-X以太网络平台优化,可扩展到具有数万个GPU的大型计算丛集。

Supermicro即将推出的SuperCluster产品包括:

● Supermicro NVIDIA HGX B200 SuperCluster,液冷型;

● Supermicro NVIDIA HGX B100/B200 SuperCluster,气冷型;

● Supermicro NVIDIA GB200 NVL72 或 NVL36 SuperCluster,液冷型。

Supermicro的SuperCluster解决方案针对LLM训练、深度学习以及大规模与大批量推理优化,与此同时,Supermicro推出了配套的L11、L12验证测试及现场部署服务体验。

也许大家有疑问,SuperCluster选择了256个H100/H200 GPU的配置,原因也很简单,256是NVlink连接的上限,更多节点的连接就需要借助Infiniband或者以太网进行扩展。

Supermicro总裁兼首席执行官梁见后表示:“我们的解决方案针对NVIDIA AI Enterprise软件提供了优化,并能够保障全球制造产能,因此得以缩短交付时间,更快提供搭配NVIDIA HGX H100和H200,以及即将推出的B100、B200和GB200解决方案。从液冷板、CDU乃至冷却塔,我们的机柜级全方位液冷解决方案可以降低数据中心40%的持续用电量。”