大多数存储厂商都不愿提及AI算力服务器本地部署的SSD,它也属于存力范畴吗?很少有厂商探路这个话题。

从本地部署到资源池池化

前不久,华瑞指数云发布了面向AI业务应用的统一AI数据平台WADP(WiDE AI Data Platform),期间,华瑞指数云CTO曹羽中从侧面给出了问题的答案。

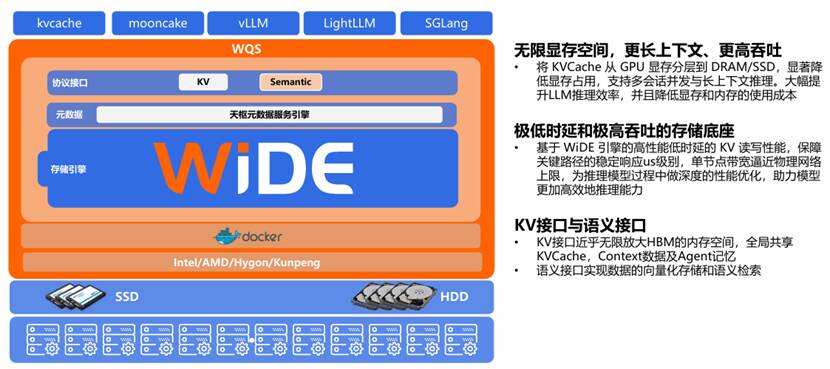

这个图看上去复杂,其关键在于WADP,它是一个纯软件,可以直接部署在AI算力节点,利用AI服务器本身的计算能力,提供统一的存储资源池的服务;当然,它也有另外一个选择,在外部独立部署,构建外部的存储资源池。

如果没有WADP,就需要借助Linux操作系统的ext4、XFS、Btrfs,或高性能场景下的ZFS(支持压缩、快照)来管理本地部署的SSD或者磁盘,将其抽象为文件和目录结构,供上层应用访问。

二者的差别有点类似业余和专业的区别,就像直连存储和外部数据存储的差别,SAN也好,NAS也好,之所以要构建外部存储资源池,很重要的原因是为了实现数据的集中共享,在存储效率、可靠性、安全性保证水平上,二者存在明显的差别。

曹羽中表示:WADP的目标是打破传统架构壁垒,使得用户无需使用不同的存储设备,分别应对不同的应用场景;无需在不同存储设备之间,拷贝和移动数据。WADP基于丰富接口,共享同一份数据,无缝互通满足关键业务应用、以及AI数据应用场景的需求。将企业核心数据与AI 能力进行融合。

“在WADP的加持下,AI计算节点没有必要部署本地SSD。”曹羽中说。

企业数据不能割裂

不同于互联网上的数据,企业拥有自己专属数据,这些数据是企业的核心资产,也是数字经济的基础核心。

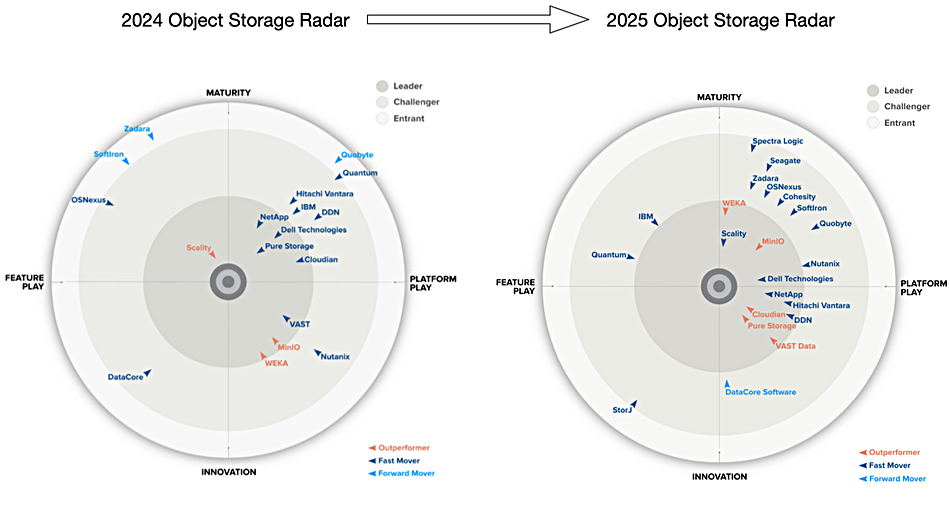

无论是SAN存储,还是NAS存储,无论是块数据、文件数据,以及后来发展起来的对象数据,共同构成了企业的核心数据资产。但AI的浪潮袭来,将企业数据与AI 能力无缝融合,就成为迫在眉睫的事情。

AI能力的实质是向量化数据的拟合,借助Transformer 架构捕捉序列的多头注意力(Multi-Head Attention)之间的复杂依赖关系,从而捕捉输入序列的语义关联(如长距离依赖、局部特征、语法/语义关系等),揭示单纯依靠人力难以发现的客观规律。 因此,企业核心数据的向量化处理是连接AI算法模型的桥梁,或者采用微调,或者采用RAG,或者训练专属小模型,这是目前企业结合AI模型较为常见的方式。

在这里,华瑞指数云的WADP让我们思考:如何用一个统一的存储架构,同时满足传统业务和AI应用的需求,避免数据的频繁移动和拷贝。要知道,企业业务应用随时随地都在快速发展和变化之中,AI业务推理也需要能够随时捕捉这种变化,最好的方法是数据共享,一份数据满足不同业务场景的需求。不能因为不同业务场景,让数据产生割裂,这是WADP的意义。

为AI在企业场景落地插上翅膀

我们知道,HBM(高带宽内存)在AI模型训练、推理中扮演着重要角色,HBM借助硅中介层(Interposer)这种独特的方式,实现了超高访问带宽,其弱点是价格昂贵,容量相对偏小,通常只有40GB ~ 141GB。

在AI训练、推理的过程中,模型的参数、激活参数、参数精度,上下文数据都要加载到HBM,因为HBM缓存容量有限,存不下太多内容,为此,模型会将部分数据下刷本地NVMe SSD,依靠PCIe 4.0、5.0进行连接。NVMe SSD在传输性能上较之HBM会有数量级上的差距。

如今专业的存储管理软件,如WADP,为AI训练、推理提供了全局共享的存储资源池,为模型KV Cache存储提供了近似无限的访问空间,如此一来,无限空间的存储资源池可对于长下文KV Cache数据进行保存,以存代算,提高模型推理的性能和响应能力(模型推理涉及多轮对话,会将上一轮对话输出结果与新的对话内容一并提交,作为新一轮对话输入,其中,涉及已经计算过的内容,已经被保存在KV Cache缓存中,无需重复计算,因此提升推理的速度)。

用曹羽中的话讲:WADP为模型提供了一个近似无限空间的HBM扩展内存空间,尽管在性能上与HBM存在差距,但弥补了HBM容量不足以及无法全局共享的弱点,性能差距可以通过流水线并行和IO预加载等解决,全局共享的无限空间的KVCache池理论上可以做到把推理过程中计算出来的所有的KV值持久化下来,通过存储IO读取KV来代替GPU的重复运算,可以大幅降低推理算力需求。

WADP的能力在最新一轮专业评测中得到验证。

最新的AI Storage权威评测MLPerf Storage v2.0测试结果显示,华瑞指数云(ExponTech)WADP软件在Resnet50模型训练测试中,单客户端支持的GPU卡数和带宽均位居世界第一,Llama3模型的Checkpoint写入带宽排世界第三,但WADP方案仅使用了其他评测方案的1/5数量的SSD盘,因此如果以Checkpoint写入带宽/容量来计算写入效率,ExponTech WADP方案排名将遥遥领先,位居第一,展示了WADP存储软件极为高效的硬件利用效率。

不同于市场上现有的打补丁的产品升级方法,华瑞指数云WADP为实现一份数据服务不同业务场景的目标,他们从零开始自主研发了一套可以适应各种IO需求的统一分布式存储引擎WiDE,同时基于全自研分布式KV系统,构建了分布式元数据引擎,满足OLTP关键业务应用,以及AI训练、推理业务的需求。新的分布式KV系统,较之现有的NAS文件系统、并行文件系统,在海量小文件的处理上,具有明显的优势,能够实现万亿级别的数据操作,以此为基础构建的WFS并行文件系统,可以完美适配AI训练对于海量小文件随机操作的需求。

基于分布式KV系统的元数据引擎就像一条线,完美串联起来了WDS、WFS、WOS、WQS等不同场景模块化存储产品的需求,这也是WADP被称为统一AI数据平台的原因。

小结

AI模型和企业数据是一个不可分割的整体,面对源源不断的业务数据,AI模型需提供具有针对性分析和推理能力,与此同时,AI模型也需要与传统的企业应用互相配合,如此才能够构建真正AI智能体,为企业业务创新创造价值。AI模型不会单独存在,需要与传统应用相互配合。

WADP从数据平台的高度为AI、传统业务应用构建了统一的数据基础,为基于AI模型的业务创新创造了良好的物质基础。据了解,WADP的4个模块化存储产品,可以分开使用,也可以彼此联合,发挥协同的优势。从这个意义来说,WADP是一个真正具有平台意义的产品,它紧紧抓住了AI时代企业业务创新的重点和关键。