在AI技术快速迭代的背景下,Supermicro聚焦AI基础设施的革新之道,围绕技术创新、生态合作与高效部署三大核心,与AMD联手通过硬件优化、冷却技术突破与开放生态构建,为大规模AI集群提供高效、环保且低成本的解决方案。

在当地时间6月11日召开的AMD Advancing AI 2025峰会上,Supermicro组织了以“筑基人工智能未来(BUILD FOR WHAT’S NEXT IN AI)“为题的论坛,与AMD专家阐述了数据中心和机架规模的未来部署、端到端解决方案、液冷等内容。

战略聚焦:以规模与效率驱动AI基础设施升级

作为增长最快的AI OEM供应商,Supermicro明确自身并非单纯的合同制造商,而是通过精准捕捉市场需求实现快速增长——从2023财年的71亿美元营收跃升至2024财年的149亿美元,预计2025财年营收有望实现250亿美元、2026 财年营收将可能达到 400 亿美元。

这一乐观预期的核心驱动力在于对部署规模与效率的深耕以及技术的突破:Supermicro在制造基地配备了18MW电力容量,可实现系统级与集群级测试;当前每月产能达5000个机架单元(RUs),其中液冷产品占2000个机架单元,为大规模AI集群验证与交付奠定基础。

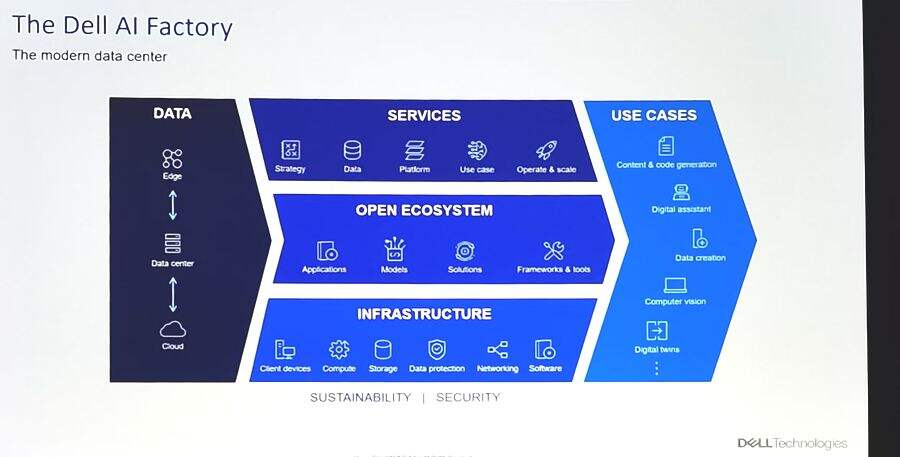

Supermicro专家认为,AI基础设施与传统计算存在本质差异,需从系统、机架到数据中心全层级优化。因此,Supermicro针对性布局液冷技术、冷却设备(如冷却器、水塔)及配套硬件(冷板、冷却分配单元CDU等),同时关注电源、重量、空间等数据中心级要素,避免部署中因准备不足导致的效率损耗,确保客户投入的资金快速转化为实际价值。

技术突破:液冷技术成大规模部署核心支撑

液冷技术作为本次演讲的重点,被视为解决大规模AI集群能耗与效率问题的关键。相比传统风冷,液冷在效率提升上优势显著:通过对CPU、GPU、内存甚至电源采用液冷方案,可实现40%的效率提升,目标是将液冷效率优化至98%。

液冷技术的价值还体现在环保与运维优化上:一方面,液冷能减少风扇依赖,降低噪音污染;另一方面,通过优化冷水机组设计,可大幅减少数据中心用水量,兼顾高效与环保。此外,液冷方案通过紧凑化设计缩减布线与交换设备的空间占用,进一步降低基础设施投资,为高密度AI集群部署提供可能。

生态协同:与AMD深度合作加速产品落地

Supermicro与AMD的合作是推动AI基础设施落地的核心动力。双方合作从2017年6月发布的Radeon instinct MI25系列延续至此次最新发布的MI 350/355系列,形成“联合开发-早期测试-快速上市”的高效链路。Supermicro作为首批将AMD技术推向市场的厂商,已实现MI 350x系统交付,且MI355x风冷与液冷服务器于当月正式出货,所有性能数据均经Supermicro硬件验证,并获第三方机构(如Signal 65)背书。

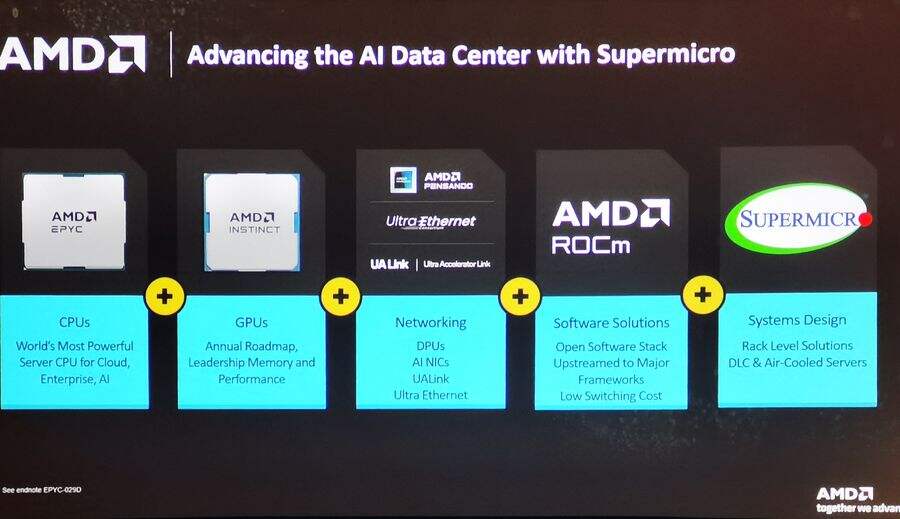

AMD则以开放生态强化合作根基:硬件上,其EPYC系列CPU凭借高频调谐技术为AI负载提速17%,Instinct系列GPU(如MI 355)持续领跑性能;软件上,ROCm平台以免许可、全开放特性支持主流框架与编译器,加速开发者创新;网络层面,通过参与Ultra Ethernet Consortium等组织,推动InfiniBand、RDMA等技术标准化,实现集群级网络性能与效率双提升。

客户实践:从技术验证到规模化落地的价值闭环

Supermicro通过展示实际客户案例印证了技术方案的可行性。

全球大型基础设施服务商Vultr依托Supermicro与AMD的技术,实现了每月300万个实例部署,覆盖云服务、GPU即服务等场景,凭借高性能与透明定价为客户节省30%-60%成本,并通过FedRAMP等合规认证拓展企业级市场。

专注AI GPU集群的Tensor Wave则部署了全球首个大规模全液冷MI325x集群:该集群位于美国亚利桑那州,单机架功率密度达100-120千瓦,通过热交换器技术实现低噪音、低温环境运行,专为大规模AI训练优化,已支撑客户在RNA视频生成等场景实现高效推理与训练。此外,Tensor Wave计划于数月内推出更大规模的MI350集群,进一步验证AMD生态的规模化能力。

开放未来:以生态协同加速AI创新落地

Supermicro强调,与AMD及客户的协同是推动AI基础设施进步的核心。Supermicro通过与AMD联合优化硬件、验证性能,确保技术快速转化为产品;AMD以开放战略(硬件、软件、网络标准)降低创新门槛;客户则通过大规模部署反馈需求,形成“技术-产品-应用”的正向循环。

从液冷技术突破到全栈生态构建,Supermicro与AMD的合作不仅为AI基础设施提供了高效解决方案,更印证了“技术创新+生态协同”是应对AI规模化挑战的必然路径,为行业持续输送高效、环保且可落地的AI基础设施蓝图。