导读

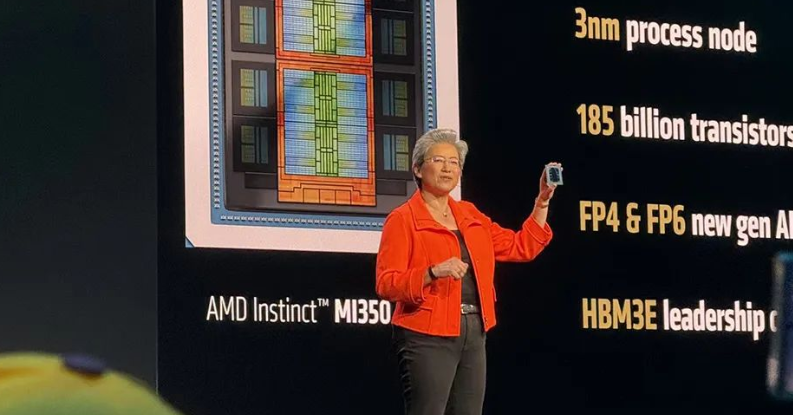

美国加州圣何塞,2025年6月12日——AMD年度AI盛会“Advancing AI 2025”现场,CEO苏姿丰手持新一代Instinct MI350X GPU,向全球展示AMD在人工智能计算领域的最新突破。

“真正的AI创新需要开放与合作,”苏姿丰面对满座的技术专家和行业领袖宣布,“从芯片到软件再到整个生态系统,我们正在构建一条通向高效AI计算的开放之路。”

这场盛会不仅推出了性能飞跃的MI350系列AI加速器,更展示了完整的端到端集成AI平台愿景。AMD首次披露了与OpenAI深度合作的下一代MI400路线图,同时推出全新ROCm 7软件栈和开发者云服务。

文字编辑|宋雨涵

1

硬件革命:

MI350性能飞跃与Venice双核架构

AMD此次发布的Instinct MI350系列包括MI350X(风冷)和MI355X(液冷)两个型号,代表着公司在AI加速器领域的重大技术跨越。

据苏姿丰介绍,MI350系列的内存容量是英伟达GB200的1.6倍,在多个精度下的运算表现优于英伟达GB200和B200。在FP4精度下,当运行DeepSeek-R1或Llama3.1时,MI355每秒可以产生比英伟达B200多出20%~30%的tokens(词元),表现与更昂贵的GB200相当。与竞争对手的解决方案相比,客户投资MI355,每美元的投资能多生成40%的tokens。

按照规划,AMD2023年推出Instinct系列的MI300X芯片,2024年推出MI325X,这两款芯片都采用CDNA3架构。据苏姿丰介绍,通过推出MI300X和MI325,AMD的芯片已经在微软、Meta、甲骨文等公司进行了大规模部署,在过去9个月里,AMD新增了很多Instinct客户。目前,头部的10个AI厂商中,有7家在自家的数据中心使用Instinct,包括OpenAI、Meta、xAI、特斯拉。

新推出的MI350系列芯片则采用AMD最新的CDNA4架构。“MI350实现了Instinct系列史上最大的一次性能飞跃,”苏姿丰在主题演讲中强调,“它为我们客户的生成式AI和高性能计算需求设立了新标准。”苏姿丰表示,MI355在本月早些时候开始生产出货,第一批合作伙伴将在第三季度推出相关平台和公有云实例。她表示,在MI355之后,AMD已经在深入开发下一代的MI400,MI400将于2026年推出。OpenAI CEO山姆·奥尔特曼则上台表示,OpenAI已经在使用AMD的MI300X芯片做一些工作,他期待后续MI450的表现。

这些芯片采用台积电第二代3nm制程工艺,集成了惊人的1850亿个晶体管,比上一代MI300系列的1530亿增加了20%以上。内存配置更是大幅升级,搭载了288GB HBM3E内存,带宽达到每秒8TB。

与此同时,AMD还预览了基于Zen 6微架构的下一代EPYC “Venice”处理器。这款采用台积电2nm工艺的服务器CPU首次在同代产品中提供双核心架构选项:

- Zen 6c高密度核心:256核设计,适用于容器化部署和AI推理集群

- Zen 6高性能核心:96核设计,聚焦HPC和AI训练场景

Venice处理器通过创新的双轨核心架构,为不同AI工作负载提供了精准的算力支持。

2

软件与生态:

ROCm 7的进化与开发者云服务

此外,AMD在会议上正式发布了其开源AI软件栈的最新版本——ROCm7。该软件栈的推出旨在应对生成式AI和高性能计算工作负载不断攀升的需求,全方位且显著地优化开发者的整体使用体验。

ROCm7在多个方面实现了升级。它增强了对行业通用框架的支持力度,进一步拓展了硬件兼容范围,还引入了一系列全新的开发工具、驱动程序、API以及库,旨在加快AI开发和部署的进程。无论是AI推理还是训练环节,ROCm7都增添了更多全新功能。

与上一代ROCm6相比,新一代ROCm7在推理性能上平均提升了3.5倍,在训练性能上提升了3倍。

如今,ROCm的应用范畴已拓展至企业级AI领域,无论是不同的操作系统平台,还是复杂的集群管理,ROCm都能提供有力支持。

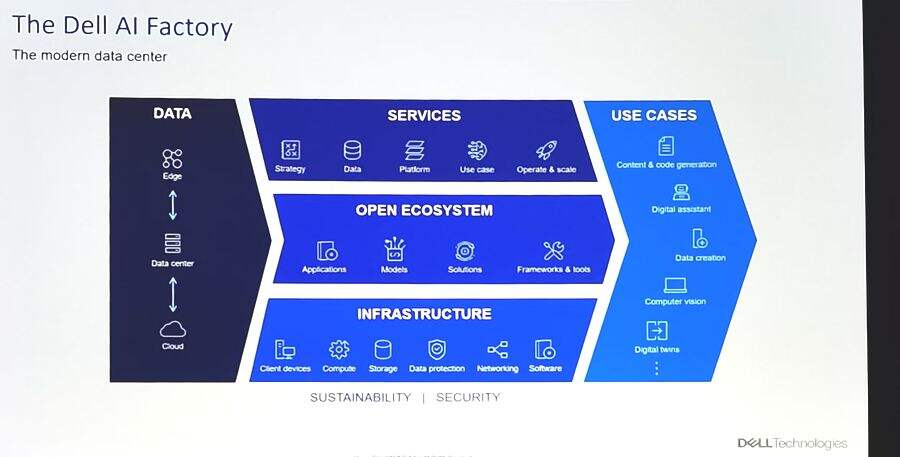

为降低开发者门槛,AMD同时宣布全球开放AMD Developer Cloud。这项服务为开发者提供完全托管的云环境,使他们能够快速获取启动AI项目所需的工具和灵活性,实现无限扩展。

AMD的客户分享了他们利用AMD AI解决方案训练当下领先AI模型、开展大规模推理以及加速AI探索和开发的经验。Meta详细介绍了Instinct MI300X在Llama 3和Llama 4推理中的广泛应用,还表达了对MI350及其计算性能、单位TCO性能和下一代内存的期待。Meta表示将继续与AMD在AI发展路线图上紧密合作,包括未来Instinct MI450平台的规划。

Oracle云基础设施(OCI)是首批采用AMD开放式机架规模AI基础设施和AMD Instinct MI355X GPU的行业领军者之一。OCI借助AMD CPU和GPU为AI集群提供均衡、可扩展的性能,并宣布将推出由最新AMD Instinct处理器加速的泽塔级AI集群,该集群配备多达131,072个MI355X GPU,助力客户大规模构建、训练和推理AI。

此外,HUMAIN、微软、Cohere、RedHat等合作伙伴也分享了相关产品的应用情况。

未来路线图:

MI400与OpenAI的深度合作

AMD的产品路线图展现出前所未有的“激进”态势。依据Lisa Su博士公布的规划蓝图,AMD计划以约每年一次的频率发布新品:MI325X将于2024年第四季度上市,MI350系列定于2025年推出,MI400系列则会在2026年面世。这一发布节奏与英伟达“一年推出一款AI GPU新品”的计划直接形成对标,彰显出AMD已做好与英伟达展开长期、持续正面竞争的准备。

从目前掌握的信息来看,AMD Instinct MI400系列将实现跨代性能的巨大飞跃,为大规模训练和分布式推理提供完整的机柜级解决方案。其关键性能创新亮点包括:配备432GB的HBM4内存;拥有19.6TB/s的内存带宽;具备40 PFLOPS的FP4性能和20 PFLOPS的FP8性能;以及300GB/s的横向扩展带宽。

更具战略意义的是,AMD首次公开承认了与OpenAI的深度合作关系。公司明确表示MI400系列是与OpenAI联合研发的,OpenAI为训练和推理需求提供了重要反馈。

此外,AMD还推出了Helios AI机柜基础设施。该基础设施从底层架构着手构建,旨在将下一代领先的硬件——涵盖AMD EPYC“Venice”CPU、Instinct MI400系列GPU和Pensando“Vulcano”AI智能网卡——与ROCm软件统一整合,形成一个完全集成的解决方案。

Helios被设计为一个统一系统,支持一个紧密耦合的纵向扩展域,最多可容纳72个MI400系列GPU,提供每秒260太字节的纵向扩展带宽,并支持Ultra Accelerator Link。

结语:

聚光灯下的MI350系列与Venice双核处理器,不仅是AMD技术的里程碑,更是其开放生态战略掷地有声的宣言。当苏姿丰与奥特曼同台,预示着顶级AI玩家正积极寻求打破单一供应格局,而AMD的硬件迭代、软件进化与能效革命,恰好提供了极具吸引力的替代方案。

挑战英伟达的霸主地位绝非朝夕之功,CUDA生态的壁垒依然高耸。但AMD正通过差异化路径破局:以极致的推理性能、突破性的能效比,以及真正开放的ROCm生态,精准切入大模型部署与绿色计算的痛点。甲骨文13万GPU的超级AI集群部署、OpenAI的深度合作背书,都证明了市场对“第二选择”的强烈渴求。

未来之争,将超越单纯的算力比拼。MI400与Helios平台勾勒的愿景,是“系统级优化”的终极形态——从芯片、互联到软件栈的垂直整合,旨在最大化实际工作负载效率。而2030年机架级能效提升20倍的承诺,则直指AI规模扩张的核心瓶颈,将可持续发展从口号变为核心竞争力。