(本文作者谢世诚,发自圣和塞)6月12日,AMD在圣和塞召开的Advancing AI 2025峰会上发布了在人工智能业务以及数据中心战略方面的最新创新成果。这些成果包括已经量产交付的AMD Instinct MI 350系列,2026年将要发布的Instinct MI 400系列,以及重要的市场拓展和客户应用快速增长的发展势头。

目前Instinct系列已经在全球十大人工智能公司中有7家进行了大规模部署。

MI 350系列发布: 高性能人工智能和科学工作负载解决方案

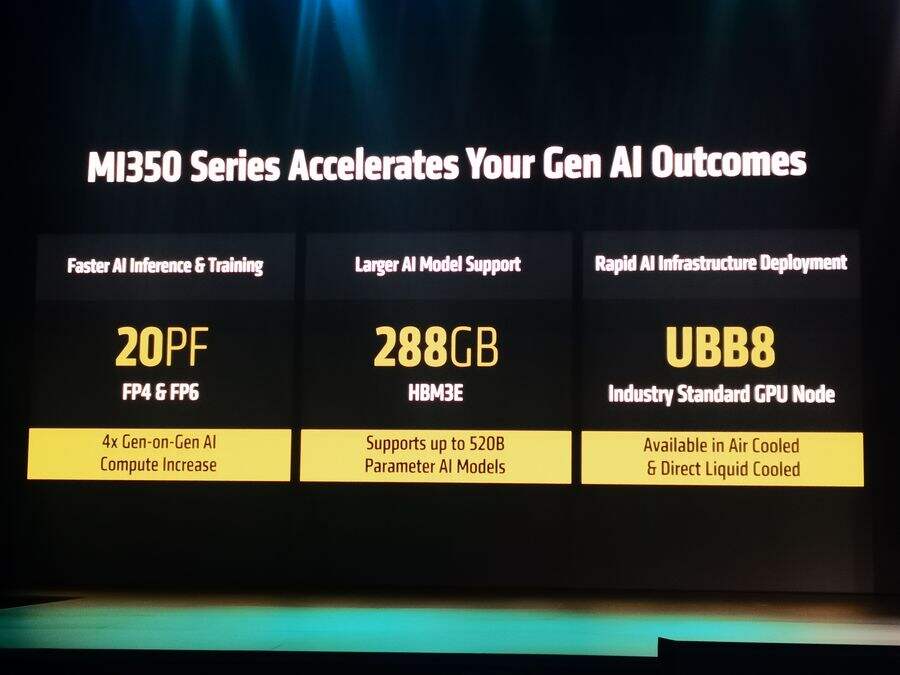

基于3nm制程的MI350系列代表了迄今为止最先进的AI平台,它包括355x和350x两个版本,是继2023年、2024年Instinct MI 300A/X及MI325之后的升级产品。MI350系列两款产品共享相同的CDNA3架构、288GB HBM3E内存容量和具有竞争力的8TB/s带宽,以及针对AI和科学工作负载的增强计算能力,在FP6、FP60、FP4、FP6和FP64格式方面具有显著优势,其TDP (热设计功率) 范围在1000到1400 W之间。

AMD Instinct 355x以更高的系统功率提供最高性能,主要针对液冷部署,可以在单个机架中扩展到96或128个MI 355X GPU;350X专为低功耗的气冷式而设计,支持在单个机架中为传统数据中心部署提供多达64个MI 350X GPU。

两种架构的解决方案本月开始生产并发货,预计第三季度将推出合作伙伴服务器和CSV实例。

在应用场景方面,MI 355X 比上一代的MI300X推理能力提升3倍以上。基于Llama 3.1 405B平台测试结果显示,MI 355X用于人工智能代理和对话机器人的性能提升4.2倍,内容生成方面提升高达2.9倍、以及3.5倍的预训练吞吐量,会话人工智能提升2.6倍,可为热门 AI 模型提供更强大的支持,有效推动AI 技术在不同领域的应用与发展。

在满足下一代推理需求的最流行的DeepSeek R1、Llama 3.3 70B、Llama 4 Maverick等 AI模型方面,MI355X 的性能分别为 MI300X 的 3 倍、3.2 倍和3.3 倍,表明 MI355X 在处理复杂 AI 模型推理任务时具备更强的计算能力和效率,能够更好地满足不断增长的下一代推理需求,为AI模型的高效运行和应用提供了有力的硬件保障,推动 AI 技术在更多场景下的落地与创新。

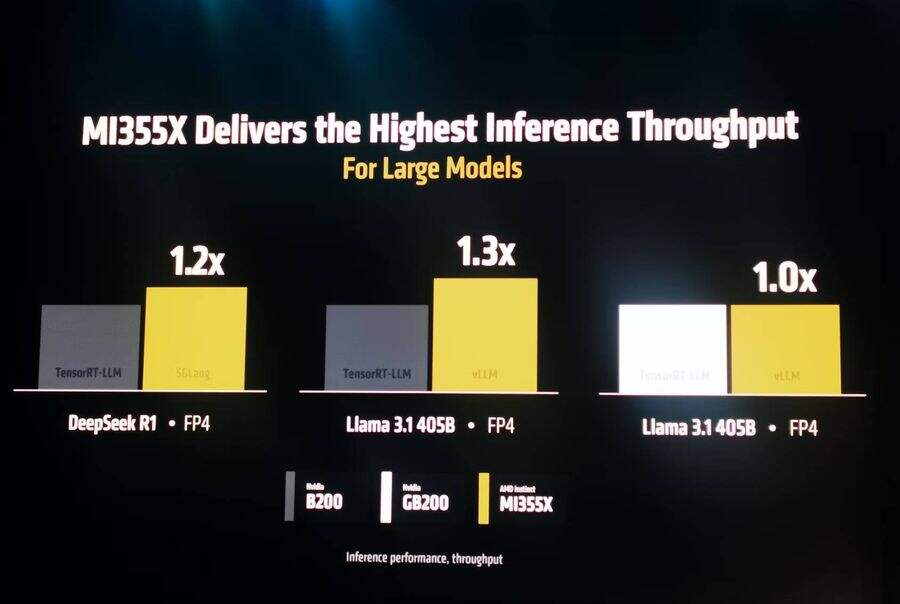

与市场上同类或更优秀产品相比,MI355X GPU也有着不俗的表现。FP4精度条件下,DeepSeek R1 和Llama 3.1 405B模型中,分别使用 SGLang和vLLM框架时,MI355X在大型模型推理吞吐量方面的性能是NVidia B200的1.2 倍和1.3 倍;在 Llama 3.1 405B 模型中使用 vLLM 框架时,MI355X 的性能可与NVidia的GB200性能媲美。这表明 MI355X 在处理大型模型时,能提供更高的推理吞吐量,展现出了卓越的性能优势。

与NVidia B200相比,MI355X最多可增加40%的Token/美元。

今天推出的AMD ROCm 7以及AMD开发者云,可帮助各类型研发人员工作更加轻松、更加高效快捷。伴随AMD AI生态系统的不断扩展,ROCm正在被越来越多开发者所广泛采用,促进了可扩展、开放式的AI创新。

AMD Instinct MI350系列机架基础设施完全建立在开放标准上。

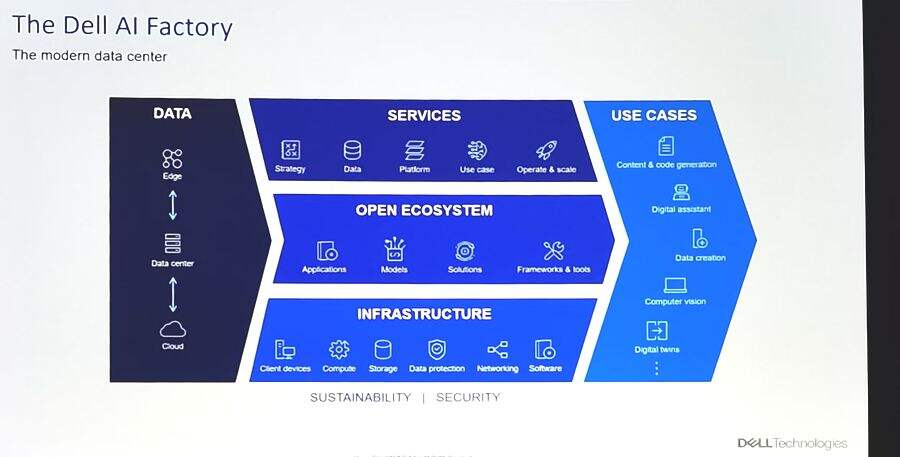

MI 350服务器解决方案包括行业标准组件,并在一个完全开放的基于标准的机架中提供。它们与第五代EPYC CPU、MI 350或355系列GPU以及用于基于Ultra Ethernet Consortium(超以太网联盟、UEC)的AMD Pensando Pollara 400 NIC集成在一个超大规模环境的解决方案中。

AMD Instinct系列是AMD面向高性能计算(HPC)、数据中心和人工智能(AI)应用推出的加速卡产品线,广泛适用于CSP、新型云计算以及 OEM /ODM领域,并扩展到关键客户的新产品所需的AI工作负载支持。

大幅增长的AMD的GPU业务

AMD与众多企业建立了合作伙伴关系,为其提供基于Instinct系列的计算解决方案。这些企业涵盖了金融、医疗、交通等多个行业,通过利用AMD的加速卡技术,企业能够加速人工智能应用的开发和部署,提高自身在数字化转型中的竞争力。

在市场和客户动力的推动下,AMD的GPU业务正在大幅增长。 提前开始生产的MI350系列已经赢得了Azure、Oracle和新的云合作伙伴等主要公共云平台上的支持。

在今天的Advancing AI 2025峰会上,Oracle、微软、RedHat等众多合作伙伴的代表纷纷登台,被称为ChatGPT之父的人工智能实验室OpenAI联合创始人、首席执行官Sam Altman 的登台,为峰会掀起一阵高潮。

下一代 Helios AI机架和MI 400 GPU细节披露

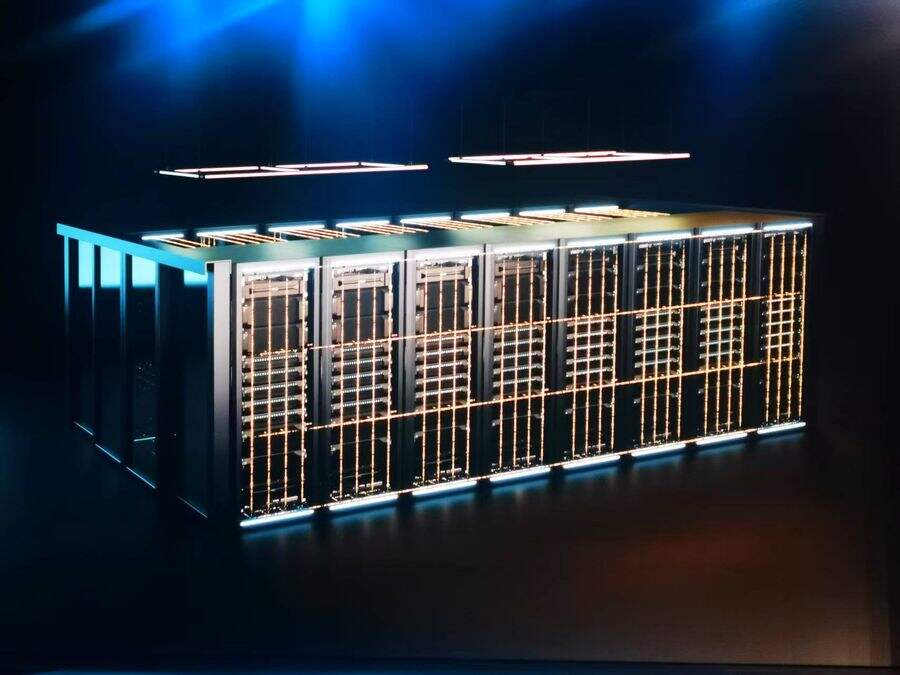

专为大规模AI模型训练和推理而设计、预期于2026年发布的Helios是一个完全集成的AI机架解决方案。

而作为Helios核心的MI 400 GPU,则是AMD为大规模训练和分布式推理而构建的最先进的加速器,其具有40 PF的FP4性能及20 PF的FP8性能、高达432GB的HBM4内存容量、19.6TB/s内存带宽和以及300GB/s横向扩展带宽,支持数千亿到数万亿的参数模型,成为2026年大规模训练和推理领域性能最高的AI加速器,预计性能比前几代产品提升10倍。

这些优势将转化为更快的模型训练和更好的推理性能,以及对客户非常有利的经济效益,有望在AI性能和经济方面树立新标准。

毫无疑问,MI 400系列也将推出一系列风冷和液体冷却选项的解决方案,以满足大型数据中心对能耗方面的要求。

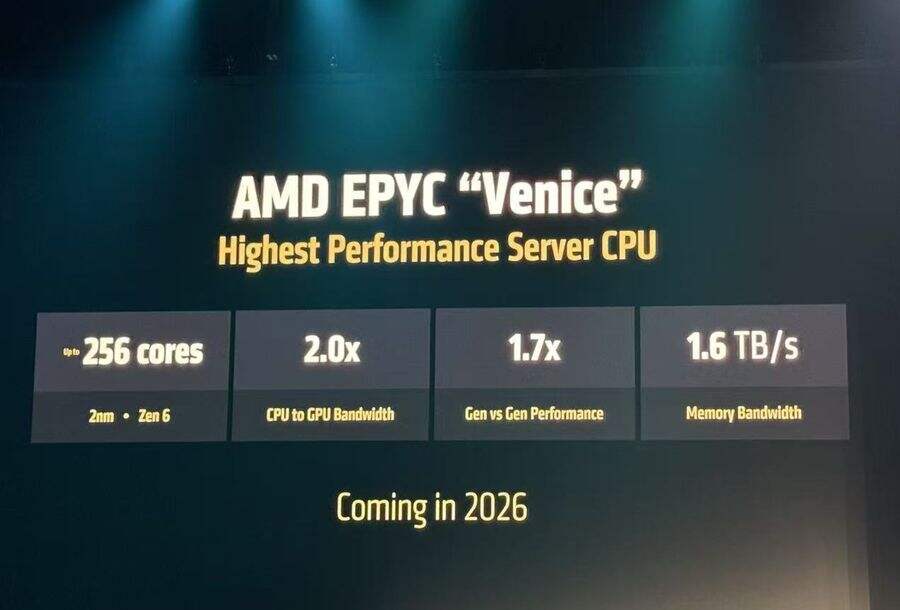

引人关注的下一代EPYC CPU处理器 “Venice”,其发布已经提上日程。

按照人工智能基础设施年度推进计划,AMD将在2027年及以后进一步重新扩展架构,将新的GPU架构、EPYC CPU解决方案和Pensando NIC整合到解决方案中。

创建包容、开放的AI生态,助力世界人工智能领域的发展稳步前行

AMD Instinct系列的多样化产品能够满足不同国家和地区在主权人工智能建设中的多样化硬件需求。无论是针对科研机构的高性能计算需求,还是企业的人工智能应用开发需求,Instinct系列都能提供相应的加速卡产品。

AMD还积极与各国科研机构合作开展人工智能相关的研究项目,从而针对性地优化Instinct系列加速卡的性能和功能。这种合作也有助于推动人工智能技术的创新发展,加速新技术在人工智能计划中的应用。