导读

2025年6月30日,百度正式宣布开源文心大模型4.5系列,一次性推出10款开源模型,涵盖从47B参数的混合专家(MoE)模型到轻量级0.3B稠密型模型,覆盖文本与多模态多种任务需求。

这一动作不仅兑现了百度今年2月宣布的“6月30日开源”承诺,更标志着百度成为国内少数实现“框架层与模型层”双层开源的科技企业。

文字编辑|宋雨涵

1

开原生态迎来新格局

10款模型同步开源

此次,百度一次性发布了10款文心大模型4.5系列开源模型,在独立自研模型数量占比、模型类型数量、参数丰富度、开源宽松度以及可靠性等关键方面,均展现出了十足的诚意。

值得一提的是,文心大模型4.5开源系列针对MoE架构,提出了一种创新性的多模态异构模型结构。

这种结构适用于从大语言模型向多模态模型进行持续预训练的范式。它不仅保持甚至提升了文本任务的性能,还显著增强了多模态理解能力。而其优越性能的实现,主要得益于多模态混合专家模型预训练、高效训练推理框架以及针对模态的后训练等关键技术。

此外,文心大模型4.5开源系列均采用飞桨深度学习框架,以实现高效训练、推理和部署。在大语言模型的预训练过程中,模型FLOPs利用率(MFU)高达47%。

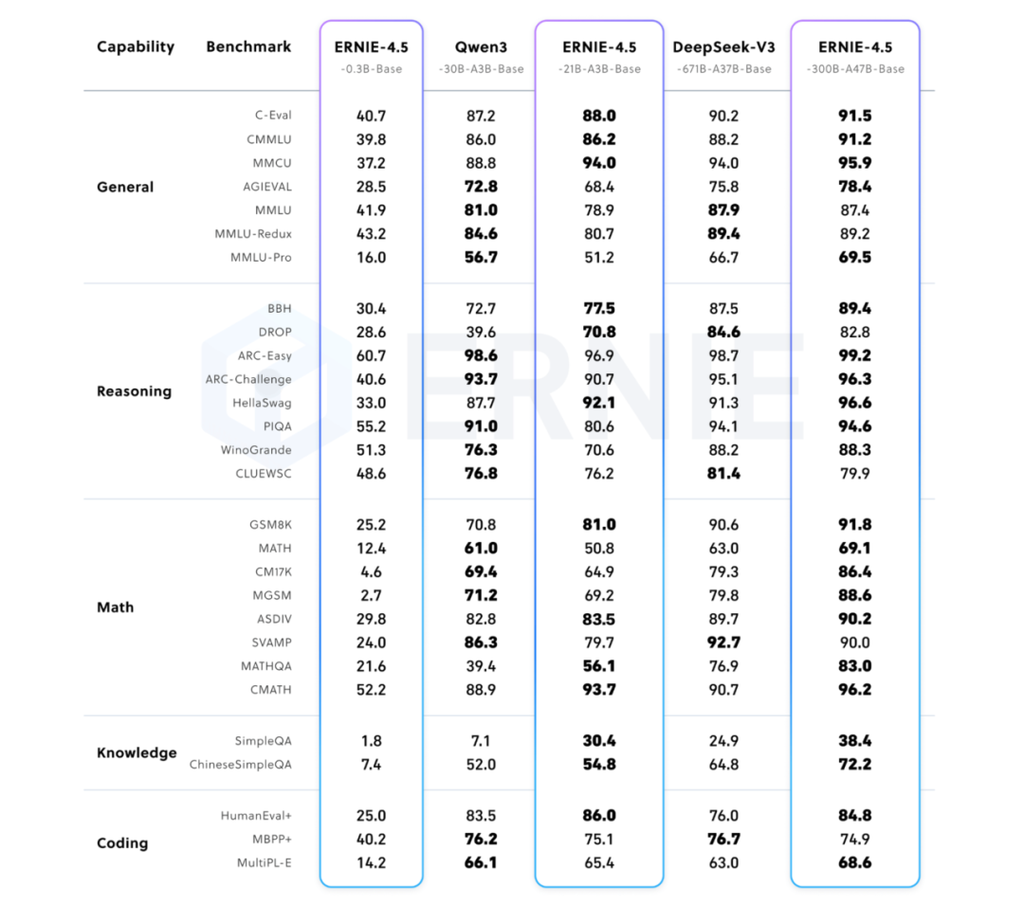

▲ 文心4.5系列模型在Benchmark上效果体现

百度此次开源不仅是模型权重和代码的开放,更配套升级了全栈开发工具链:

- 文心大模型开发套件ERNIEKit:提供开箱即用的模型微调工具

- 大模型高效部署套件FastDeploy:支持多种芯片适配,降低部署门槛

- 广泛硬件兼容性:支持从云端服务器到边缘设备的全场景部署

这种“模型+工具链”的开源模式,标志着百度从单纯的技术输出转向生态构建的战略升级。

2

文心4.5系列开源模型核心技术亮点

多模态异构架构领跑AGI赛道

文心4.5系列的核心创新,在于其针对MoE架构提出的多模态异构模型结构。这一设计解决了从大语言模型向多模态模型持续预训练的关键难题——在保持文本任务性能的同时,显著增强多模态理解能力。

关键技术突破点包括:

■ 多模态混合专家模型预训练

通过模态隔离路由和异构专家并行策略,实现文本与视觉模态的联合训练,避免模态间干扰。

■ 高效训练推理框架

为了支持文心4.5模型的高效训练,百度提出了异构混合并行和多层级负载均衡策略。通过节点内专家并行、显存友好的流水线调度、FP8混合精度训练和细粒度重计算等多项技术,显著提升了预训练吞吐。

推理方面,提出了多专家并行协同量化方法和卷积编码量化算法,实现了效果接近无损的4-bit 量化和2-bit 量化。此外,我们还实现了动态角色转换的预填充、解码分离部署技术,可以更充分地利用资源,提升文心4.5 MoE 模型的推理性能。基于飞桨框架,文心4.5在多种硬件平台均表现出优异的推理性能。

■ 针对模态的后训练

每个模型采用了 SFT、DPO或UPO(Unified Preference Optimization,统一偏好优化技术)的多阶段后训练。

市场格局的重塑:

从“堆参数”到“重效率”的转向

开源浪潮推动了市场格局从“参数竞赛”向“效率竞争”的转向。传统闭源模型依赖高额授权费构建商业模式,而开源模型通过免费策略快速占领开发者市场,再通过云服务、行业定制等增值服务实现盈利。例如,百度文心一言的免费开放,虽面临短期亏损压力,但通过扩大用户基础,为后续商业服务铺路。阿里则聚焦基础模型研发,中小企业基于开源开发垂直场景应用,形成“大模型后市场”,覆盖医疗、电力、金融等领域,衍生出智能巡检、AI客服等解决方案。

端侧智能与隐私保护需求的崛起,进一步加速了市场分化。开源模型推动端侧AI爆发,联想、华为等厂商在PC、手机端部署本地化模型,实现隐私数据零上传。DeepSeek开源的低成本推理技术,使消费级显卡可运行亿级参数模型,加速了智能终端的普惠化。这种“端侧+行业”的创新模式,不仅解决了通用云端模型的差异化需求难题,还通过训推一体机厂商的硬件优化,将模型部署周期从月级缩短至天级,推动了AI在制造、能源等高隐私要求行业的落地。

结语:

百度通过开源文心4.5系列,不仅展示了在多模态架构、高效训练、量化技术上的领先性,更以实际行动力推大模型技术普惠。文心4.5系列的开源,恰是为这场效率革命按下了加速键。当技术民主化的浪潮席卷产业,真正的赢家或许是那些在开源土壤中破土而出的万千创新者——他们手执效率之刃,正在切开智能世界的新截面。