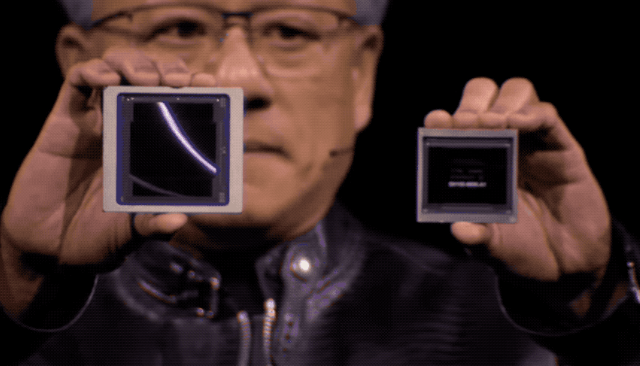

今年的GTC大会,英伟达再出王炸级产品——Blackwell GB200 “超级芯片”。新一代GPU基于 H100 进行了升级,内存带宽提高了 1.4 倍,内存容量提高了 1.8 倍,提高了处理生成式AI任务的能力。

GB200:2080 亿个晶体管,高达 20 petaflops FP4 计算能力

GB200 结合了两个 GPU 和一个 Grace CPU,可以为 LLM 推理工作负载提供 30 倍的性能,同时还可能大大提高效率。Nvidia 表示,与 H100 相比,它的成本和能耗 “最多可降低 25 倍”,训练一个 1.8 万亿个参数的模型以前需要 8,000 个 Hopper GPU 和 15 兆瓦的电力。如今,2000 个 Blackwell GPU 就能完成这项工作,而耗电量仅为 4 兆瓦。

Nvidia 称,在具有 1,750 亿个参数的 GPT-3 LLM 基准测试中,GB200 的性能是 H100 的 7 倍,而 Nvidia 称它的训练速度是 H100 的 4 倍,其中一项关键改进是采用了第二代变压器引擎,通过为每个神经元使用四个比特而不是八个比特,将计算能力、带宽和模型大小提高了一倍。第二个关键区别只有在连接大量 GPU 时才会出现。

此外,新一代 NVLink 交换机可让 576 个 GPU 相互连接,双向带宽达到每秒 1.8 TB。Nvidia 打造了一个全新的网络交换芯片,该芯片拥有 500 亿个晶体管和一些自己的板载计算功能。FP8 的运算能力为 3.6 teraflops,在此之前,一个由 16 个 GPU 组成的集群将有 60% 的时间用于相互通信,只有 40% 的时间用于实际计算。

为应对企业大量采购,英伟达发布了 GB200 NVL72液冷机架系统。GB200 NVL72可将36 个 CPU 和 72 个 GPU 集成到一个液冷机架中,可实现总计 720 petaflops 的 AI 训练性能及1,440 petaflops的推理性能。其内部有近两英里长的电缆,共有 5000 条独立电缆。机架上的每个托盘包含两个 GB200 芯片或两个 NVLink 交换机,每个机架有 18 个前者和 9 个后者。Nvidia 称,其中一个机架总共可以支持 27 万亿个参数模型。消息称,GPT-4 的参数模型约为 1.7 万亿。亚马逊、谷歌、微软和甲骨文都已计划在其云服务产品中提供 NVL72 机架。

DGX SuperPOD:适用于万亿参数级的生成式 AI 超级计算

同时,英伟达推出了Blackwell 架构 DGX SuperPOD,可将集群中 Grace Blackwell 超级芯片的数量扩展至数万个,通过 NVIDIA NVLink将多达 576 块 Blackwell GPU 相连,总共288 个 CPU、576 个 GPU、240TB 内存和 11.5 exaflops 的 FP4 计算能力。Nvidia 表示,其系统可以扩展到数万 GB200 超级芯片,并通过全新 Quantum-X800 InfiniBand(最多 144 个连接)或 Spectrum-X800 以太网(最多 64 个连接)与 800Gbps 网络连接在一起。