2023 年 11 月 14 日消息:英伟达宣布推出 同样基于 Hopper 架构的NVIDIA HGX H200。作为H100的升级版,H200 可以更好地处理生成式 AI 与高性能计算工作负载。

NVIDIA H200 是首款采用 HBM3e 的 GPU,其运行更快、更大的显存容量将进一步加速生成式 AI 与大语言模型,同时推进用于 HPC 工作负载的科学计算。

凭借 HBM3e,NVIDIA H200 能够提供传输速度达 4.8 TB/秒的 141GB 显存。与上一代架构的 NVIDIA A100 相比,其容量几乎翻了一倍,带宽也增加了 2.4 倍。

H200 的推出将带来进一步的性能飞跃,比如在一个 700 亿参数的 LLM —— Llama 2 上的推理速度比 H100 提高了近一倍。随着未来软件的持续升级,H200 有望实现更大的性能优势与提升。

NVIDIA H200 的规格

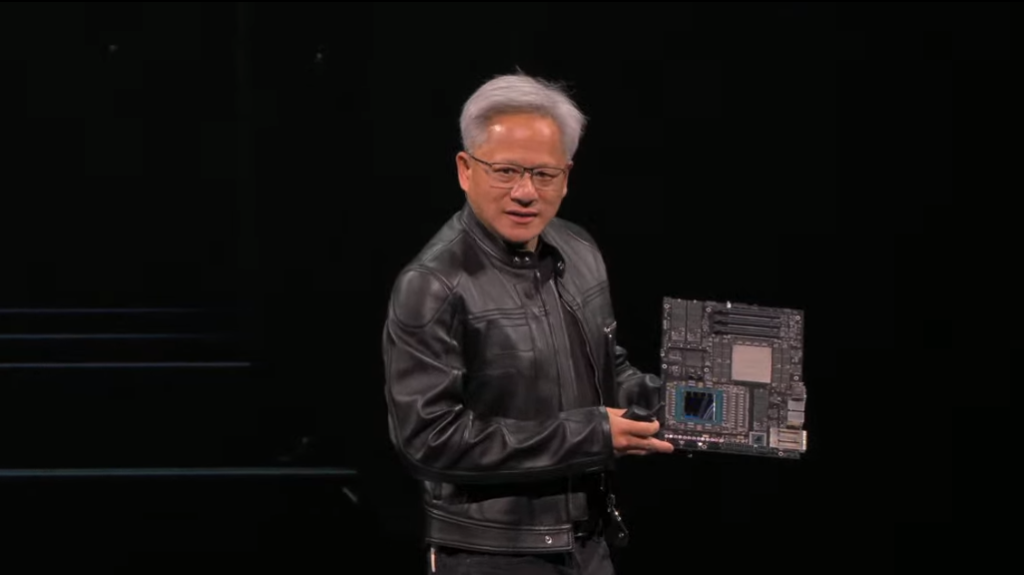

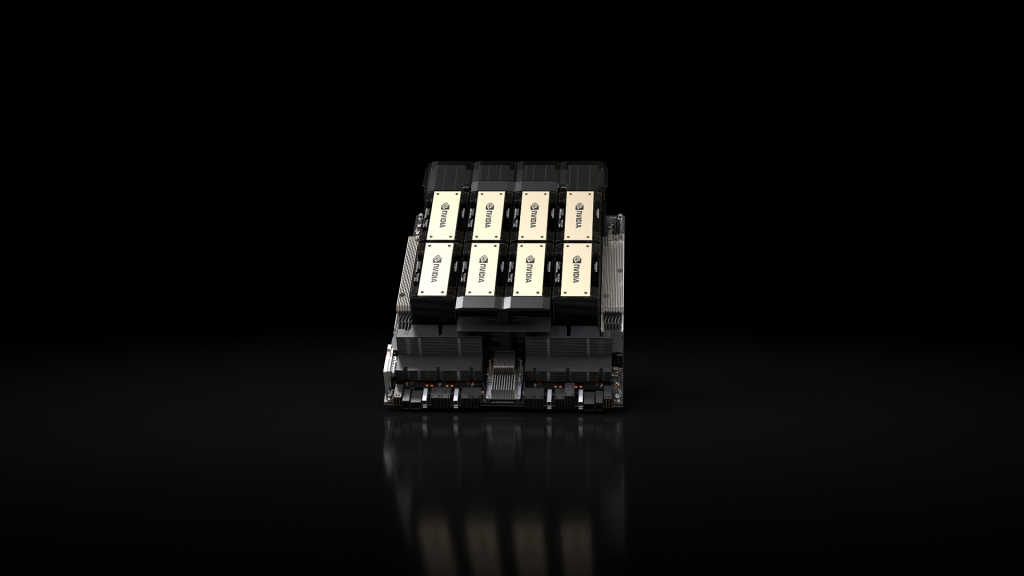

NVIDIA H200 将提供四路和八路 NVIDIA HGX H200 服务器主板可选,其与HGX H100 系统的硬件和软件都兼容。

H200还可用于今年 8 月发布的采用 HBM3e 的 NVIDIA GH200 Grace Hopper™ 超级芯片。这些配置使 H200 可以部署在各类数据中心,包括本地、云、混合云和边缘。

在 NVIDIA NVLink 和 NVSwitch 高速互连技术的加持下,HGX H200 可为各种应用工作负载提供最高的性能,包括针对 1750 亿参数以上超大模型的 LLM 训练和推理。

八路 HGX H200 可提供超过 32 PetaFLOPS的 FP8 深度学习计算能力和 1.1TB 的聚合高带宽内存容量,能够为生成式 AI 和 HPC 应用带来强劲性能。

当H200 与采用超高速 NVLink-C2C 互连技术的 NVIDIA Grace CPU 搭配使用时,就组成了带有 HBM3e 的 GH200 Grace Hopper 超级芯片——专为大型 HPC 和 AI 应用而设计的计算模块。

大型服务器厂商和云厂商预计于 2024 年第二季度开始提供搭载 H200 的系统。