我们知道,以ChatGPT为主导的生成式AI工具正在与不同行业亲密协作,一些存储企业已经在开拓自己的新思路了,比如SK海力士。

SK海力士的新思路——给生成式AI工具提供高性能存储芯片

高效算力和高存储容量是AI学习和推理模型的基础。ChatGPT等生成式AI应用要从大量训练数据中学习生成和输出高质量内容。为了实现关键词识别、图像识别等功能,AI模型要存储大量的图片和音频信息。AI应用还必须具备快速处理数据的能力,能把AI计算结果实时输出给用户,因此对存储芯片的数据传输速度提出了更高要求。但目前为止,向生成式AI工具提供高性能存储似乎还未引起大家足够的重视。

前段时间,SK海力士正式推出了一款高性能、大容量、高带宽的内存芯片,把12个DRAM芯片层连接在一起,提供24GB的DRAM,目的就是抢夺AIGC等计算密集型市场红利。

SK海力士用高带宽内存 (HBM) 绕过 x86CPU插槽,把DRAM连接到CPU。相比CPU插槽的途径,HBM有更直接、基于中间层的处理器连接方式,具有更高带宽,用HBM3时带宽高达 819GBps,可以有效提升训练学习和计算期间的服务器性能。继2022年6月SK海力士开始量产16GB容量的8层HBM3芯片之后,顺风搭上AIGC,SK海力士开启了新征程。

SK海力士的一位发言人表示:“公司成功开发了24GB的封装产品,内存容量比之前的产品增加50%。 ……今年下半年开始向市场提供新产品,以此满足由AI驱动的聊天机器人(如ChatGPT)行业对高端内存产品的增长需求。”白话翻译过来就是,采用大语言模型工具的企业数量激增,大幅提升GPU的销售量,相应地GPU需要大量内存还有采用HBM技术进行提速,我们的机会就来了!

图片来自网络

回顾一下什么是HBM

High Bandwidth Memory (HBM) 是一种基于3D堆叠工艺的DRAM内存芯片,缓存和内存组CP,利用TSV(硅通孔技术)实现垂直堆叠,这样的设计能让交换数据的时间大大缩短,但要适配不同型号的芯片带还要匹配大小,成本高,现在主流应该使用的是2.5D封装,都很适用于AI,机器学习和数据中心等规模型应用。

图片来自网络

与平面板级连线不同,通过interposer的特殊有机材料(线宽,节点间距优于电路板)作为中间转接层,就像一个有底座的硅芯片,连接多个DRAM芯片堆栈,实现高密度和高带宽。目前HBM主要安装在GPU、网络交换设备(如路由器和交换机)、AI加速器、超级计算机和高效服务器上。

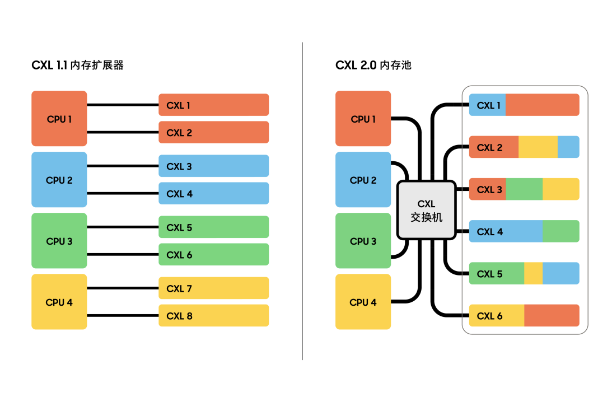

未来随着DRAM与存储器之间的价格和速度差距不断缩小,围绕DRAM和SRAM的近内存计算更符合AI应用需求,2.5D封装是过渡期的最优选。当然除了HBM,CXL(Compute Fast Linking)等新存储技术与软件优化相结合,也会提高应用中存储容量和性能。

这不,现在三星也推出了自己首款支持CXL 2.0的CXL DRAM。基于CXL 2.0的128GB CXL DRAM将在今年量产,为高性能服务器系统中和CPU一起使用的加速器、DRAM和存储设备提高效率,满足人工智能和机器学习应用高速处理数据的需求。所以诸位,CXL连接要继续加油呀!

图片来自网络

除了HBM和CXL,还有企业在用自然语言实时查询其组织的数据库/数据湖,国外有家数据库初创公司SingleStore就通过投喂给ChatGPT矢量函数实现SQL查询功能,但通用基础的功能很好用,再深入一些还会有结合点吗?

该怎么和ChatGPT玩耍,该怎么和生成式AI应用玩耍,这是个问题。在5月26日,百易传媒(DOIT)即将在苏州中茵皇冠假日酒店召开的2023数据基础设施技术峰会上,这也是话题之一,聚焦AIGC带来的数据变革以及行业的创变之道,我们汇集了来自众多业内专家学者、企业代表,还有制造、互联网等领域用户代表,以期了解最新行业动态,增进交流,加快行业创新。

苏州紫藤花尽开,静待众人来~