在上一篇文章《到底什么叫“近线存储”? 》中,我们提到了硬盘的单位容量性能并没有与时俱进,甚至出现了倒退。这具体是什么意思呢?

什么单位容量性能

基本上所有存储器都存在容量增加,但性能并不一定能同步增长,甚至出现倒退的问题。如果再将带宽这类指标做分子,容量做分母,我们就会发现,每单位容量的性能会随着分母增大而所下降。

对于DRAM、SSD这类高速的半导体存储介质而言,单位容量性能被“摊薄”的情况主要出现在同代产品范围内。以Solidigm旗下最受欢迎的D7-P5520为例,我们将各个容量点的性能整理为下表:

从这个图表中可以了解企业在存储选型中的几个关键常识:

1,随着容量提升,总体性能会有所增加;

2,最佳总体性能通常出现在最高或次高容量SKU中;

3,随着容量增加,单位容量(每TB)性能会有所下降。

对于硬盘而言,同一代的产品则基本上不存在常识1和2的情况,在转速、单盘密度相同的情况下,能同时读写的只有1组磁头和1面盘片,因此盘片数量对性能没有什么影响。1

而SSD的NAND介质可以同时多通道访问,更多的颗粒可以提高并行性能(常识1),直到遇到控制器的通道数和接口上限(常识2)。

最关键的认知就是常识3,而且极具普适性。从硬盘时代到SSD当家的当下,只要是对性能有明确要求的场景,服务器们都采取了用较小容量、较多数量的盘来获取较高的性能的思路。以上一篇曾经提到的2.5英寸高速硬盘为例,其中最大容量的型号完全没法与同时期的3.5英寸硬盘比容量,连十分之一都没有,但可以通过数倍的安装数量来获取更高的总体IOPS。

为了优化硬盘的单位容量性能,还产生了一种“过度配置”的策略,就是不充分利用硬盘的容量,譬如仅使用一半。其中的原因一方面是尽量部署更多的硬盘,另一方面是因为硬盘内外圈的访问速度落差较大,让数据安排在较外圈可以获得相对高的吞吐量。

如果再把单位容量成本考虑进来,通过多块硬盘提升性能就更不划算了。因为硬盘的定价与容量的关系是非线性的,而SSD的定价与容量之比基本稳定。换句话说就是,两块较小的SSD的总价,与一块容量翻倍的SSD的单价差不多;而两块较小容量的硬盘的总价通常高于一块大容量的硬盘。这也是硬盘放弃性能竞争而专注于改善容量价格比的关键经济原因,使用大量小容量的硬盘在企业级存储/数据中心当中会付出过多的采购成本、机架空间、能耗的代价。

与时俱进与逆水行舟

前面对于SSD单位容量性能的比较强调限于“同代”。SSD的代际提升是非常迅猛的,而且这种高速发展的势头已经持续了十几年。以目前Solidigm新一代的D7-PS1010为例,它各个容量点的性能相对同容量的D7-P5520都是翻倍的。

D7-PS1010在同代内的单位容量性能也符合递减的规律,但跨代相比时,多数指标能够保持了“以一当二”优势。这种优势源于接口带宽(PCIe总线)、主控性能、NAND介质性能的全面提高。单纯从接口带宽的发展速度看,PCIe接口大致保持了三年左右翻倍的势头,过去十年内完成了PCIe 3.0、4.0、5.0的普及,业内正在为PCIe 6.0平台进入市场做准备。

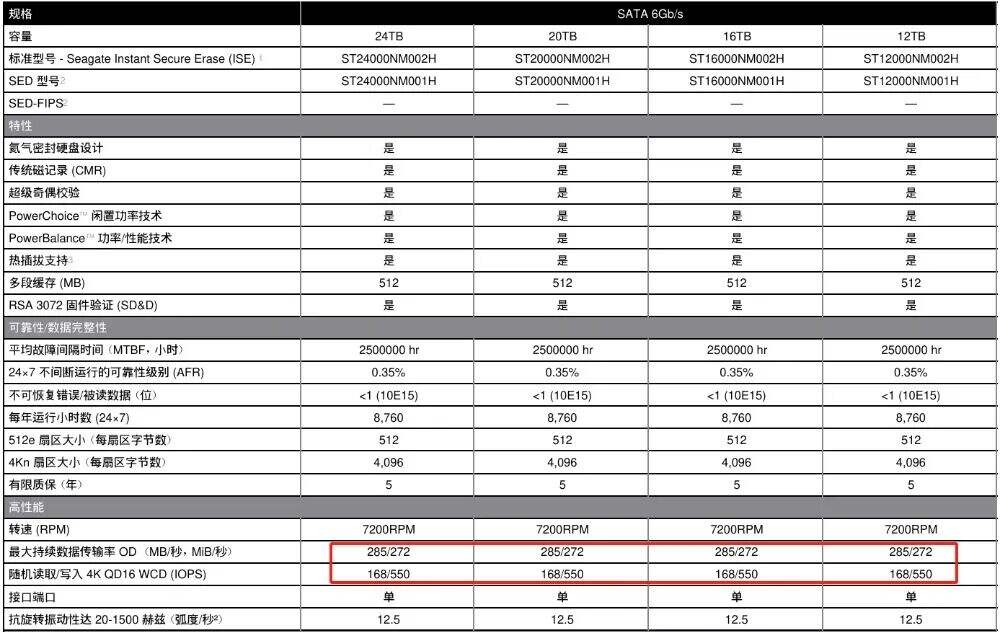

相较于NVMe SSD的快速迭代,硬盘的接口速度已经停滞,常用的SATA 6Gb/s和SAS 12Gb/s都已经沿用了超过10年时间,从未成为硬盘性能发挥的瓶颈。在决定硬盘性能和容量最关键的指标单碟密度方面,3.5英寸1TB单碟的硬盘是2011年发布,1.6TB单碟是2017年发布,3TB单碟则是2025年才进入市场,相应的最大传速率只是从250MB/s左右提升到290MB/s左右。以30TB硬盘计,每TB传输率不到10MB/s,IOPS甚至低于10。

SSD的创新与需求细分

SSD在快速发展的过程当中,并不是简单的新旧替代,而是针对不同的用户需求有所侧重,从而逐步扩大了应用场景的范围。

譬如Solidigm D7-PS1010使用PCIe 5.0接口,适合最新的服务器平台,面向工作负载繁重、算力饱和且昂贵的场景,典型的如AI服务器。而对于负载比较传统、处理器内核数不太多的主流服务器,则更喜欢PCIe 4.0 SSD,如Solidigm D7-P5520。

针对写入强度的差异,同一代的SSD至少也会分为读写均衡型(标准耐用度)和写密集型(增强耐用度),分别对应1和3的DWPD参数,譬如D7-P5520与D7-P5620,或D7-PS1010与D7-PS1030的关系。增强耐用度的SSD通常用于更新频繁的数据库、索引盘等用途。

如果要求更高的写入强度、更低的写入时延,部份SSD厂商还会提供SLC SSD,譬如Solidigm D7-P5810。这类SSD可以作为缓存/缓冲盘使用,甚至可以部分替代系统内存。

随着用户逐步认识到多数应用是读多写少,QLC SSD的接受度也在不断提高,典型的使用场景包括CDN、超融合、大数据,以及AI训练数据集等。尤其是数据量大、功耗预算紧张的AI集群,非常乐于使用Solidigm D5-P5336为代表的超大容量的QLC SSD构建容量层以替代传统的硬盘阵列。

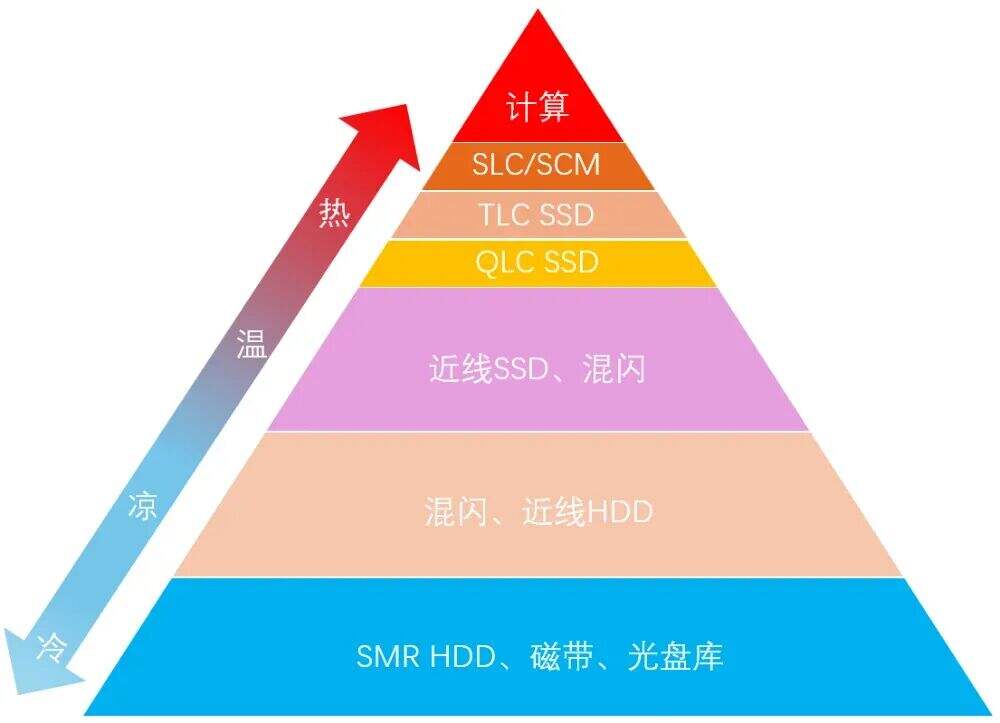

如果对主流的NVMe SSD进行粗略的划分,在线存储部分至少可以根据不同NAND介质的性能特点分成三层,分别对应SLC、TLC、QLC SSD。

实际上,根据前面的介绍,TLC SSD内部依然可以做细分,分为高性能的PCIe 5.0 SSD和高性价比的PCIe 4.0 SSD。QLC SSD其实也会有所细分,譬如成本略高、兼容性更好、性能较好的Solidigm D5-P5430可以部分替代PCIe 4.0 TLC SSD,还有容量更高、成本略低的D5-P5336用于对吞吐量和存储密度有较高要求的容量层。

QLC SSD需要更多创新

Solidigm D5-P5336这类超大容量SSD目前最热衷的使用场景是AI集群的全闪存储节点。这种SSD即使用上百TB的容量做分母,其每TB性能仍远高于硬盘。

以122.88TB为例,每TB顺序读性能是30TB硬盘的5倍以上,随机读IOPS是上千倍。如果使用容量较小的型号,单位容量性能还会有数以倍计的提升。这背后还代表了一个企业级用户特别在意的问题:可预期性能。SSD的可预期性能仍有很大的浮动空间,如果希望获得较高的可预期性能,付出的成本可控。而硬盘的可预期性能处于下滑趋势中,适合其存储的数据会越来越“冷”。即使用混闪来改善硬盘存储的性能问题,但还是无法从根本上解决预期性能问题——一旦数据没有被缓存命中,仅有个位数的IOPS会带来严重的响应延迟。

针对混闪下限逐步降低且难以预期的性能,业内在推动QLC单层存储方案解决温存储问题,面临的主要障碍还是QLC SSD的单位容量成本明显高于硬盘。考虑到QLC存储节点可以消除过度配置(硬盘有效容量无法充分利用、缓存盘不贡献可用容量),以及更积极地使用数据缩减、数据放置技术,QLC存储的单位容量成本并没有想象中那么高。

除了通过架构设计和提升运维水平精打细算,SSD本身的单位存储物理成本还需要进一步下降。在PLC技术进入市场之前,QLC SSD还有优化成本的空间——毕竟QLC SSD的性能依旧相对硬盘有数量级的优势,如果我们允许可预期性能下浮,还是有机会获得降本空间的。

譬如从网络基础设施角度看,数据中心、企业内的主流网络是25~100G,一两块SSD就能够跑满整个网络带宽,配置更多的SSD只是扩展了容量,性能则完全浪费。在当前主流QLC SSD与硬盘之间,规划一种目标性能、功耗低于前者,但单位容量性能仍明显高于后者的SSD,更适合承担主流近线存储场景的任务。近线SSD只需要提供当前主流SSD几分之一甚至十分之一的性能,都不会在当前主流网络设施内出现性能瓶颈,但可预测性能依旧优于硬盘阵列甚至混闪几个数量级。

近线SSD概念的出现,改善了目前主流QLC SSD全闪阵列与混闪阵列之间成本落差过大的问题,并彻底解决混闪在部分温存储场景中性能不足的窘境,构建出新的存储分层图景。近线存储场景消耗的存储空间巨大,也为SSD的未来发展提供了更广阔的天地。在后继的文章中,我们将对近线SSD的潜在优化方向做一些分析。当下我们审视近线SSD还难免带有许多现有SSD产品特征的影子,把它作为QLC SSD扩展使用场景的一种努力。在巨大的市场潜力之下,未来的近线SSD很有可能走出一条相对独立发展的路线,优化的主控、特化的NAND介质等等。