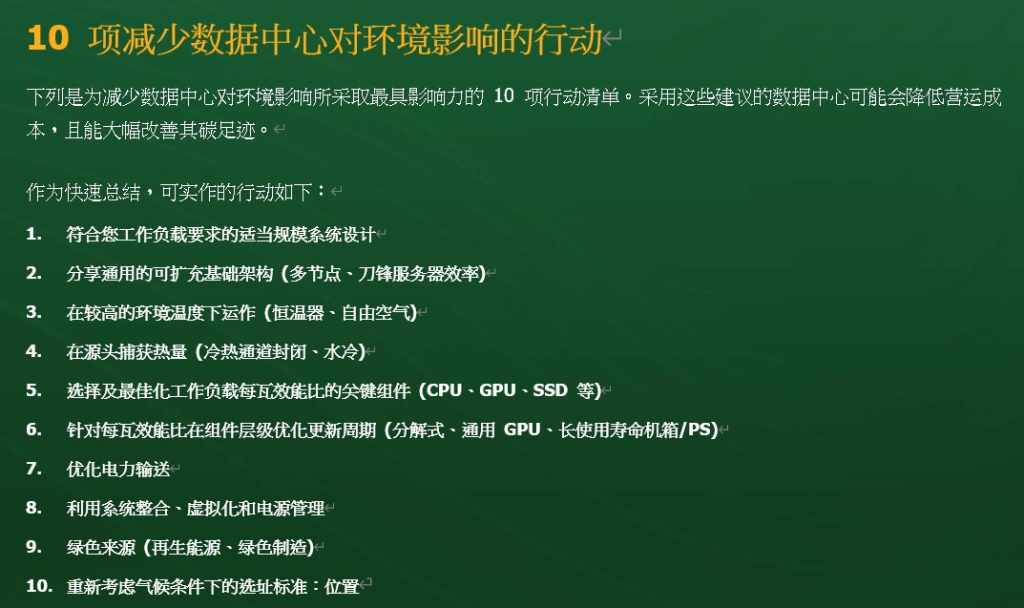

近年来,随着数字化转型、私人网络与实时、超低延迟的应用迅速发展,以及以ChatGPT为代表的高密度算力需求爆发,预计未来几年,算力基础设施规模将迎来新一波快速增长。与之伴随而来的巨大能耗增长和碳排放将成为新的挑战。以数据中心为例,全球数据中心每年至少要耗费200兆瓦的电力,约占全球能源使用量的2%。而据估算,到2030年前此数据将继续成长到4%至8%。如何应对诸多挑战,成为数据中心势不容缓的问题。在日前发布的《绿色运算:实现绿色数据中心的10大最佳实务》白皮书中,Supermicro列举了10项旨在降低数据中心运营成本,大幅度改善碳足迹的解决措施。

其实这10大措施并不难理解,除了其中对于绿色能源来源、绿色制造、以及对于气候条件下地理位置的选址此类较为容易直观理解的措施以外,其中提到的多节点、刀片服务器,冷热通道封闭和水冷技术,虚拟化、电源管理等技术,均能带来公认行之有效的节能效果,但是当下而言,很多都尚未像虚拟化技术一样得到普遍推广应用。

其中的原因何在?

“绿色目标”当前,在政策强导向之下,发展“绿色”算力成为数据中心领域的重中之重。人人都知道“绿色”算力的重要性,但对于如何落实,为双碳目标作出实质性的贡献,其中具体措施却尚需推广和普及。在这众多可以减少数据数据中心对环境的影响对策中,不乏切实可行,但容易被常规认知轻视的“良策”。

举个简单的例子。

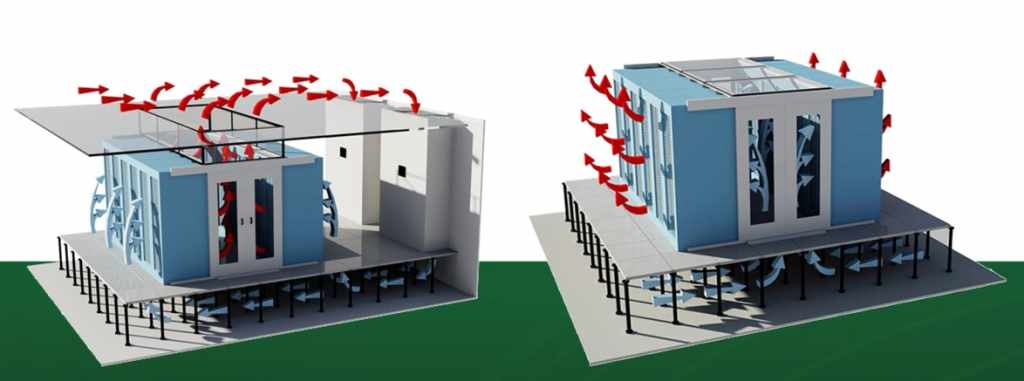

在机架的部署上,为加强散热效果,有人会选择把服务器分开摆放,而不是机器摞机器集中摆放。这个直觉性的思路源于日常生活的认知,对于数据中心而言却不尽如此——分开摆放并无必要性。机器摞机器不仅是合理的,且在没有安装机器的部分,还要增加隔板,防止制冷气流的直通。其技术原因很简单:数据中心制冷采取前送(冷)风后出风的方案,机柜则采取脸对脸、背对背的冷热通道交替的方式,并以封闭方式以减少气流混合带来的效率损失。

简而言之:无论是采取盲板或冷热通道封闭的方式,都是当下简单可行的措施,并且无需更多的投资。

但是有些措施看似简单,落实到行动上并不简单,下面以Supermicro BigTwin服务器的工程设计规格为例。

该服务器允许的操作温度高达 35℃ (95℉),但有数据显示,只有约 15%受访者表示进气温度高于 29℃ (84℉),要知道,机房室内设计温度的提高,有助于提高机房空调机组的显冷量,潜热量的减少也意味着除湿量的减少,减轻了机房的湿负荷,从而降低机房空调的加湿运行及其运行成本。对于采用冷水机组的数据中心而言,一般冷水机组出水温度提高1℃,能效比即可提高约3%,在保证制冷量满足需求的情况下,将冷冻水温度从7℃提高至12℃甚至更高,冷水机组可节约15%以上的能耗。

既然如此,为何众多的数据中心会与29℃这个门槛擦肩而过呢?这就牵涉到规模的问题,此外,除了Supermicro BigTwin之外,还会有其他类型的设备,如网络设备、存储设备,以及其他品牌型号的服务器产品,这些产品能否满足“高温”的需求,这在一定程度上就会限制“高温”数据中心的运行。

刀片服务器也是如此!

为了满足刀片服务器的散热需求,需要用户增加行级制冷设备。此外,机架供电密度,也会限制刀片服务的使用。

但是即便如此,刀片服务器、类似Supermicro BigTwin这样的节点服务器仍然具有选择的价值。因为采用了“共享”电源、散热(风扇)的设计,在效率上相较于机架式服务器更加具有优势,这应该引起用户的重视。

纵观全局,对于数据中心而言,应该主动追求“更加合理的存在”。

仍然以分解式服务器为例。

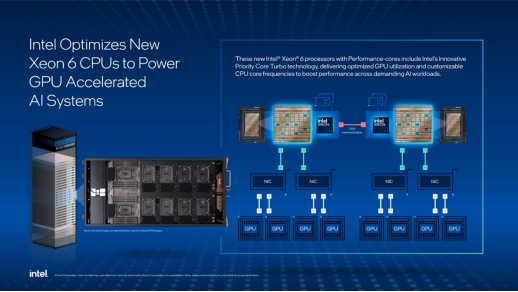

分解式架构的Supermicro 6U SuperBlade 服务器,拥有可单独升级的系统组件,如储存模块、搭载 Intel® CPU 的可分离运算模块等。这种分离的架构设计既保护了产品投资,延长了产品生命周期,也更加有益于降低数据中心的运维成本。

类似的技术细节很多:电源效率的问题,提供同样的400 瓦功率输出,使用800 瓦电源供应(50% 容量),会加之500 瓦电源供应(80% 容量) 效率更低。

大型数据中心的能源使用和电子废弃物对于环境有着极大的影响。在设计、改造或升级数据中心时,诸多可操作性高的措施都能够帮助数据中心减少营运所需的电力,从而踏上前往绿色低碳的目标的快车。《绿色运算:实现绿色数据中心的 10 大最佳实务》未必每个方案都适用于每个数据中心,但是“更加合理的存在”,应该成为数据中心达成低碳目标的合理有效解题思路,以及势不容缓的措施。