导读

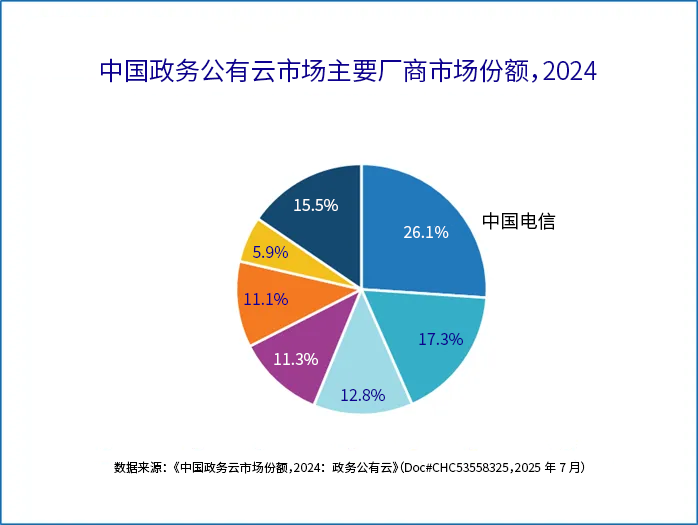

在云计算飞速发展的时代,天玑实验室作为天翼云公有云事业部的重要科研力量,专注于计算机体系结构和分离式内存在云基础设施上的应用研究。2025年7月9日,在2025全球闪存峰会的CXL技术应用论坛上中国电信天翼云天玑实验室负责人艾天翔先生从公有云底座面临的问题、Scale Up行业发展趋势、天翼云聚合计算的解题思路以及实验论证四个方面,分享了天玑实验室在通算超算Scale Up技术上的探索与实践成果。

1

公有云底座面临的问题

三大核心问题揭露发展目标

(一)算力增长不匹配

过去五年,算力规模增长4-8倍,但云厂商单个计算实例(虚拟机、容器)增长仅2-3倍,增长速度滞后于整体算力规模。

(二)资源不均问题突出

在公有云云基础设施领域,普遍存在云服务器资源售卖不均衡问题,部分资源池CPU售卖高但内存空闲多。同时,不同类型主机售卖不均,如裸金属集群畅销,而通算产品滞销,导致资源碎片化问题严重。

(三)超大规格计算实例需求难满足

SAP HANA数据库需求:SAP HANA数据库对内存需求大,是本地磁盘的4倍,需要6TB、12TB等大规格内存。央国企及大型企业的财务分析、报表系统多依赖该数据库。目前,SAP HANA头部厂商采用AWS多路服务器方案,提供12T-32TB内存实例,但价格昂贵。

大数据集群需求:行业大数据集群单节点多为96C、768G,大规模集群运维成本高。聚合计算若能扩大单节点规模,可减少集群数量,降低运维成本。

高频交易场景需求:股票交易中,每只股票数据需独立处理,单节点核数多、内存大可降低量化交易集群时间成本,增加收入。

总结来看,当前数据中心面临的核心挑战集中体现在“内存墙”“IO墙”的性能瓶颈以及公有云资源碎片化带来的效率损失。针对内存墙问题,行业形成两条主流技术路径:一是基于开放生态的CXL 1.0/1.1标准,通过内存扩展实现跨节点容量突破;二是依托华为高速互联架构,支持多节点间内存动态调度借用。对于IO墙,核心思路是利用CXL总线特性重构通信模式——传统跨节点数据搬迁可通过内存池化大幅缩减,但当前实践依赖软件层维护缓存一致性(Cache Coherency, CC),需频繁刷新内存导致效率折损。该问题将在CXL 3.0硬件级CC支持及未来华为互联技术落地后得到根本性解决。而资源碎片的根治方案明确指向池化架构,CXL 2.0标准已为此提供内存池化与共享的技术基础。

2

Scale Up行业发展趋势:

多元化的产品格局

在技术产业化层面,Scale Up生态呈现多元化产品格局:联想ThinkServer率先实现GPU与CXL内存的硬件级集成,兼具通算超算与AI推理能力;阿里云推出CXL powered PolarDB数据库,通过内存解耦降低TCO;超节点系统领域,英伟达GB200/GB300、天翼云与超聚变合作的直连式内存池方案(支持6-10TB扩展)、浪潮及新华三的国产化CXL方案共同推动架构革新;公有云服务商则竞相推出超大内存实例,如AWS 32TB规格、华为8TB实例及阿里云3TB产品,满足企业级内存密集型应用需求。

艾天翔先生表示过去五年CXL相关论文与专利量增长超200%,分离式资源池化研究同步攀升。产业界创新实践取得突破性进展——天玑实验室验证CXL替代UDP通信可使QPS提升8倍,阿里云实现CXL总线对RPC的替代。

关键技术成熟度分析显示:英特尔IFMM技术通过硬件级内存交换将访问时延压缩至130毫秒,达到近本地内存性能;CXL独立核扩展及多主机头直连架构已具备商用成熟度;开放互联协议中CXL/UCIe(UALink)生态进展领先,而NVLink、华为互联及字节ETHLink等封闭方案尚未开放生态接口。

行业发展趋势呈现三大特征:其一,国产高速互联生态进入全栈自主攻坚期;其二,技术迭代与商业落地同步加速,超大内存实例逐步覆盖企业场景;其三,跨产业协同成为破局关键,亟需芯片商、设备商与云服务商共建生态。

三、天翼云聚合计算的解题思路

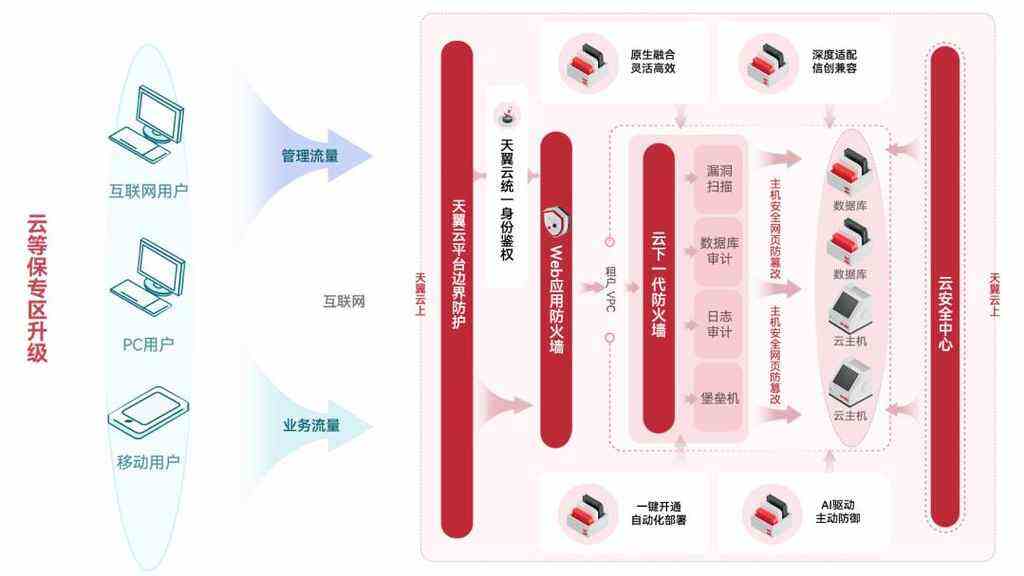

架构选择:分布式架构有Split Architecture(分布式对等架构)和Pooled Architecture(池化架构)两种。天翼云认为未来数据中心将以交换为中心,构建资源池,包括计算池、内存池、异构加速池等,以解决资源利用率低和“墙税”问题。未来天翼云作为云服务提供商,将同时兼容两种架构。

建设Scale Up能力:Rack内Scale Up方案主要有CXL2.0、UALink、NVLink;跨Rack技术目前成熟的是RDMA网络,2026年UALink、光互联等有望成熟。国内央国企面临非国产化设备采购难题,国产化设备生态进展缓慢,总线交换机商业化条件不足。

聚合计算平台核心技术:

- 智能感知与调度:未来数据中心管理对象为分离池化的超节点,对智能调度提出新挑战。

- 分布式虚拟化技术:不仅支持向下切分服务器,还支持向上聚合资源。

- 总线零拷贝通信技术:利用CXL3.2总线通信,提高数据传输效率。

- 软件定义内存:实现内存热插拔和冷热分级管理。

此外艾天翔先生披露了聚合计算产品规划:

他讲到聚合计算提出要做三款产品,第一是超聚合服务器,可以把分布式的数据中心聚合成超大的服务器,比如说多多个物理节点的CPU聚合成超大的虚拟机,以满足客户多样化需求。第二,内存即服务,把内存做成像磁盘一样可插拔的形态。第三可以通过零数据拷贝的总线通信给整个计算集群进行加速。

- 实验论证,性能效率显著提升

英特尔IFMM技术测试:英特尔IFMM技术通过硬件交换降低远端内存访问时延,无需软件搬迁。测试结果显示,开启IFMM后,内存时延与纯本地DRAM相当,平均约170纳秒,带宽也与纯本地DRAM相当。

性能测试:在小负载情况下,开启IFMM后性能比纯本地DRAM配置提升2—7个百分点;读取操作性能优秀,吞吐量可达35万QPS,时延1.8毫秒。

成本与内存利用率分析:与AWS多路服务器方案相比,聚合计算方案成本显著降低。6TB产品成本从103万降至60万,12TB产品成本从220万降至120万。同时,与傲腾方案相比,聚合计算方案内存利用率提升17%。

结语:

当前国产CXL高速互联技术生态涵盖应用软件、基础软件、服务器厂商、CXL芯片、控制器和CPU等多个环节。目前基础软件主要由国外厂商主导,国内尚未开放。天翼云希望更多厂商加入,共同推动国产CXL生态发展,解决设备采购难题,实现技术自主可控。

天玑实验室在通算超算Scale Up技术上的探索与实践,为解决公有云底座面临的问题提供了创新思路和解决方案。通过聚合计算架构和核心技术的研究,以及实验论证和成本分析,证明了聚合计算方案的有效性和优越性。未来,天翼云将继续与产业界合作,推动国产CXL高速互联技术生态的发展,为云计算行业的发展贡献力量。