导读

北京时间4月17日凌晨时分,OpenAI正式推出了两款具有划时代意义的AI模型——o3与o4-mini。这两款模型不仅具备通过图像进行复杂推理的能力,还能自主调用并整合多种工具资源,被业界专家誉为人工智能领域的一次重大飞跃。作为OpenAI“o系列”推理模型的最新力作,o3与o4-mini在训练过程中被赋予了更长时间的思考能力,即在响应之前能够进行更为深入和全面的分析。同时,它们也是OpenAI迄今为止发布的最智能、功能最强大的模型。

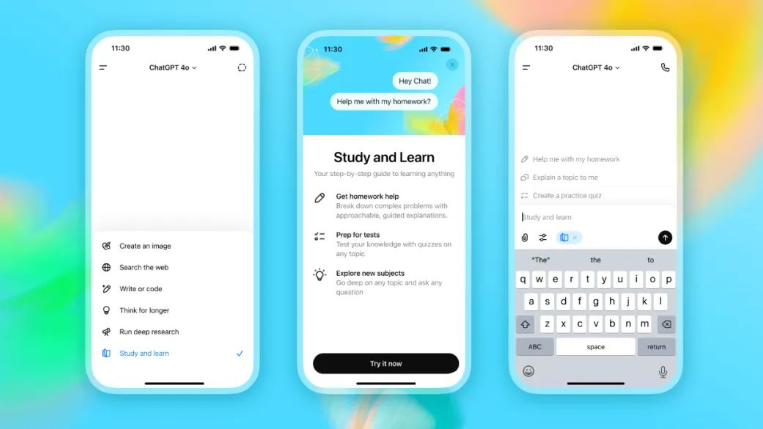

这些先进的推理模型能够自主组合并运用ChatGPT平台内的所有工具,涵盖网页搜索、利用Python编程语言分析上传的文件与数据、对视觉信息进行深度解析,甚至包括图像生成功能。尤为关键的是,它们不仅具备判断何时使用何种工具的能力,还能精确规划工具的使用方式,从而以恰当的输出格式,在极短的时间内(如一分钟内)给出经过深思熟虑的详细答复,有效解决更为复杂的问题。这一特性意味着它们能够更高效地处理多层次、多步骤的问题,赋予ChatGPT“自主执行任务”的全新能力。

文字编辑|宋雨涵

1

OpenAI核心突破

空口无凭,数据说话

o3作为OpenAI目前最顶尖的推理模型,正引领着编程、数学、科学探索及视觉感知等多个领域的革新步伐。在Codeforces、SWE-bench(无需额外定制模型框架)及MMMU等权威基准测试中,o3均刷新了SOTA(State-Of-The-Art,即当前最佳性能)记录。

o3模型特别擅长应对那些需要综合多方面知识、答案不直接明了的复杂问题,尤其在图像、图表等视觉信息的解析上展现出卓越能力。据外部专家评估,在处理高难度现实任务时,o3相较于o1模型,重大错误率降低了20%,特别是在编程、商业咨询及创意构思等领域表现尤为亮眼。

早期测试者高度评价了o3作为思维伙伴的分析严谨性,以及其在生成并批判性评估新假设方面的能力,特别是在生物学、数学和工程学等学科领域。

OpenAI新模型o3和o4-mini等在数学竞赛、编程、指令遵循和工具调用方面的表现

与此同时,OpenAI推出的o4-mini是一款轻量级模型,专为追求快速响应与成本效益的推理任务而设计。尽管体积小巧、成本低廉,o4-mini在数学、编程及视觉任务上的表现却令人瞩目,实现了性能与资源消耗的完美平衡。

o4-mini在AIME 2024及2025基准测试中脱颖而出,成为表现最优的模型。专家评估显示,在非STEM领域及数据科学等任务中,o4-mini同样超越了其前身o3-mini。得益于其高效性,o4-mini支持的使用限制远高于o3,为解决需要深度推理能力的问题提供了强大且高效的高容量、高吞吐量解决方案。

Altman发文盛赞新视觉推理模型:天才水平

图像思考与工具链自主决策

视觉推理新范式

o3和o4-mini首次将图像直接融入思维链(Chain-of-Thought),模型不仅能“看到”图像,还能通过裁剪、旋转、缩放等操作进行深度分析。即使面对模糊、倒置或低质量图片,模型仍能准确提取信息。例如,用户上传手绘草图或白板照片,模型可结合Python代码和网络搜索工具,生成可视化图表或解决方案。

工具调用智能化

两款模型被训练为“AI智能体”,可自主调用ChatGPT内置工具(如网页搜索、Python代码执行、图像生成),并动态组合使用。例如,当用户询问“加州夏季能源使用趋势”时,模型会搜索公共数据、编写代码预测、生成图表并解释关键因素,整个过程耗时不到1分钟。

OpenAI通过强化学习(RL)优化工具使用策略,模型不仅能判断“何时用工具”,还能根据任务目标灵活调整策略,例如在数学竞赛中先暴力计算再优化解法。

二、性价比质的飞跃

OpenAI称o3和o4-mini在很多情况下,它们都比各自的前代o1与o3-mini更高效,也更节省成本。在AME2025基准测试中,性价比都远远超过前代模型。

o4-mini和o3-mini在成本和性能方面的对比:

o3和o1在成本和性能方面的对比:

3

仍有三大局限性

推理链过程、感知错误、可靠性不足

推理链冗长:模型在执行任务时,可能进行大量冗余或不必要的工具调用与图像处理操作,致使思维链过长。

感知失误:尽管工具调用能正常推进推理流程,但模型仍可能犯下基本的感知错误,视觉层面的误解会直接导致最终答案出现偏差。

可靠性欠佳:在多次尝试解决问题时,模型可能会采用不同的视觉推理过程,部分过程可能导致错误结果。

未来展望

OpenAI o3和o4-mini显著提升了模型的视觉推理能力,这些模型在视觉感知任务上的提升,使其能够解决之前模型难以触及的问题,标志着模型向多模态推理迈出的重要一步。

OpenAI在博客中提到,他们将o系列的专业推理能力与GPT系列的自然对话能力和工具使用能力相结合,未来可以实现模型能支持无缝、自然的对话,同时能主动使用工具并解决更为复杂的问题。