今日,在一年一度的GTC China 峰会上, NVIDIA重磅发布其第七代推理软件开发套件——TensorRT 7。 TensorRT 7 的实时推理能力可让全球开发者完成会话式AI应用。推理延迟在过去一直是实现交互式互动的最大痛点,NVIDIA TensorRT 7为实现更智能的AI人机交互开创先河。

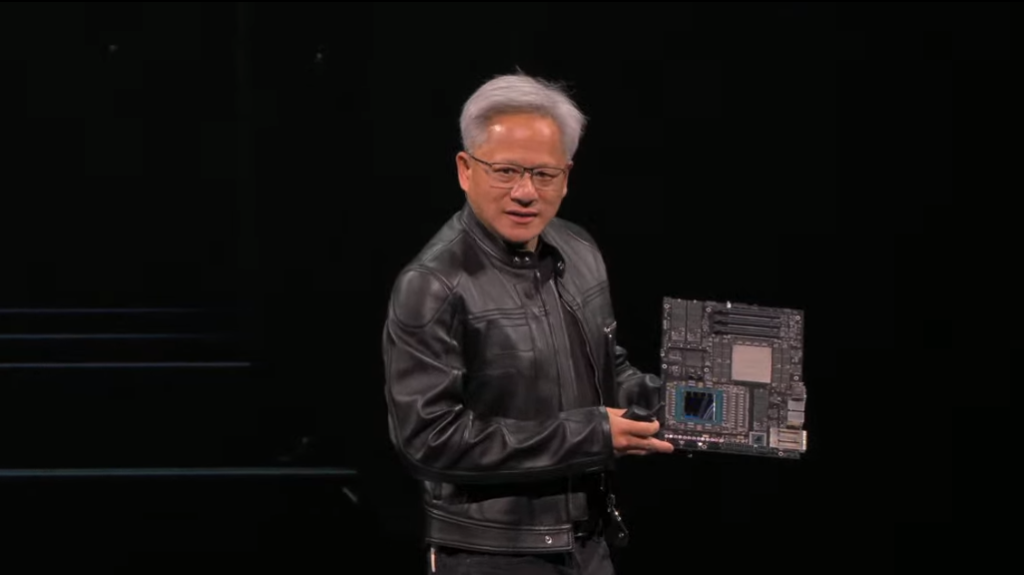

“我们已进入了一个机器可以实时理解人类语言的AI新时代。TensorRT 7使这成为可能,为世界各地的开发者提供工具,使他们能够构建和部署更快、更智能的会话式AI服务,从而实现更自然的AI人机交互,” NVIDIA创始人兼首席执行官黄仁勋表示。

据官方介绍,TensorRT 7 可实现和语音代理、聊天机器人、推荐引擎等应用的实时互动。其内置新型深度学习编译器,该编译器能够自动优化和加速递归神经网络与基于转换器的神经网络。这些日益复杂的神经网络是AI语音应用所必需的。与在CPU上运行时相比,会话式AI组件速度提高了10倍以上,从而将延迟降低到实时交互所需的300毫秒阈值以下。首批使用NVIDIA会话式AI加速能力的企业包括——阿里巴巴、百度、滴滴出行、美团、快手、平安、搜狗、腾讯和字节跳动等。

TensorRT 7加快了AI模型的领域扩展。这些模型被用于预测使用递归循环结构(RNN)的时间序列、数据情景。除了用于会话式 AI语音网络之外,RNN还可以帮助规划汽车或卫星到达时间、预测电子病历中的异常情况预测金融资产和识别欺诈。

RNN配置和功能组合的爆炸式增长为快速部署可以满足实时性能标准的生产代码带来了挑战,开发者需要花费长达数月的时间创建手写代码优化,从而使得会话式AI仅局限于拥有必要专业人才的少数公司。通过TensorRT的新型深度学习编译器,全球开发者能够将这些网络(例如定制的自动语音识别网络以及用于文本-语音转换的WaveRNN和Tacotron 2)实现自动化,并实现最佳的性能和最低的延迟。新的编译器还能优化基于transformer的模型,例如用于自然语言处理的BERT等。

TensorRT 7可以快速优化、验证并部署经过训练的神经网络,为超大型数据中心、嵌入式或汽车GPU平台提供推理能力。NVIDIA的推理平台,包括TensorRT和多个NVIDIA CUDA-X AI库和NVIDIA GPU,不只能为会话式AI提供低延迟、高吞吐量的推理能力,也同样能为包括图像分类、欺诈识别、分割、目标检测和推荐引擎在内的其它应用提供低延迟、高吞吐量的推理能力。该平台各项能力已被阿里巴巴、美国运通(American Express)、百度、PayPal、Pinterest、Snap、腾讯和Twitter等使用。

据了解,TensorRT 7 将在未来几天内开放访问,以用于开发和部署。NVIDIA开发者计划成员可通过 TensorRT 网页免费获得TensorRT 7。此外,新版本插件、语法分析器和样本也将作为开放资源,通过TensorRT GitHub 库提供。