今天我们在使用AI工具时,很少会关心每次对话到底消耗了多少算力和成本?然而,对AI服务商来说,这个问题却至关重要。因为随着用户规模和调用频率不断增长,Token成本越来越重要。

在国内,豆包是最典型的例子。有数据显示,豆包有大致1.72亿月活用户,是中国最受欢迎的移动AI工具之一。而在背后默默支撑豆包的,是字节跳动的公有云平台——火山引擎。

在火山引擎FORCE原动力大会,火山引擎总裁谭待宣布,“中国公有云上每产生两个Token,就有一个是火山引擎生产的。”这一说法的数据来自IDC,数据显示,火山引擎在2025上半年中国大模型公有云服务的市场份额高达49.2%。

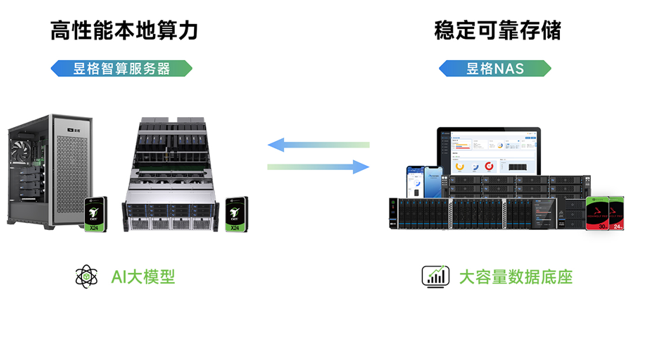

但问题也随之而来,当需要大量产出Token,AI成本压力要如何得到缓解?答案并不在模型本身,而是在底层的基础设施,包括计算、存储系统等。今天,我们的故事围绕火山存储和英特尔至强硬件加速器展开。

CPU利用率飙到了80%!存储处理负担很重

故事的主角是火山引擎的存储系统。这些年,随着RDMA、万兆网卡以及NVMe SSD技术的普及,支撑火山引擎存储的CPU负载经常能达到80%。这其中,有将近1/ 3的操作都是压缩、解压缩、加解密和CRC(循环冗余校验)等高频操作。

在在线系统中,当CPU利用率达到80%,通常意味着CPU的调度余量非常有限,请求排队和尾延迟会被显著放大,系统对突发流量和抖动的容忍度明显下降,属于需要重点关注和优化的状态。

英特尔至强处理器的硬件加速器可以卸载部分处理负载:比如,用IAA来做压缩和解压缩,用QAT来做加解密和CRC,用DSA来做数据搬运、拷贝。这是从第四代英特尔至强可扩展处理器开始就引入的硬件加速器。

不看不知道,用专用硬件替换软件加CPU的方案,确实能带来非常显著的效率提升。比如,当用一个QAT设备来运行LZ4算法时,吞吐能达到大约3.7GB/s,而如果用单个CPU核心加软件,吞吐约为800MB/s,两者相差了近5倍。

Deflate比更LZ4压缩效率高,但算法本身更复杂,当用一个CPU核心加软件,吞吐只有可怜的100MB/s,想要保持高吞吐会消耗跟多CPU资源。如果换成一个QAT设备,吞吐能达到大约3.9GB/s,两者相差了惊人的40倍。

英特尔QAT硬件加速器能显著提高压缩效率,而且,无论是吞吐能力,还是压缩比上,QAT硬件加速方案都明显优于纯软方案。除了压缩场景之外,在加解密、CRC校验以及数据搬运等任务重,硬件加速方案也有类似的效果。

为充分利用英特尔至强加速硬件,火山引擎联合英特尔开发出veSAL

英特尔至强的硬件加速器虽好,但如何融入火山引擎存储架构则是另外一个问题。虽然现有开源方案也支持硬件加速器,但在功能完整性、系统适配性以及在线存储复杂场景支持等方面,仍无法完全满足火山存储的需求,因此,双方联合开发了veSAL。

veSAL(Volcano Engine Storage Acceleration library)是一个开源软件,主要针对火山存储中会高频出现、计算量大、对性能敏感的操作(比如,如压缩/解压缩、加解密)而设计。与此前ISA-L侧重于软件优化不同,veSAL则更擅长利用硬件加速器的能力。

veSAL目前包含三大组件,Codec是压缩/解压缩模块,支持lz4、zstd、deflate、zlib算法卸载;Cypher是加解密模块,支持AES-XTS和Sha256两种算法卸载;DataFlow是数据流模块,支持CRC和MemMove卸载。

veSAL的性能很强。通过为每个业务线程分配独立的Codec channel,把压缩任务所需的QAT硬件会话、上下文和加速资源封装成线程私有通道,从而彻底避免多线程之间的资源共享和竞争,实现稳定、可预测的极致性能。

搭配英特尔至强QAT硬件加速器之后,veSAL在压缩和解压缩场景的时延和吞吐表现都得到了极大提升,相较于原来基于单核CPU驱动veSAL这种纯软方案而言,优势非常明显。

在时延表现上,在LZ4算法中,纯软件方案在小数据块还有一定时延优势,但随着数据块变大,软件方案的时延呈线性增长。而基于英特尔QAT硬件加速的veSAL时延增长更为平缓,对数据规模的敏感度显著降低。

而在吞吐能力方面,在LZ4算法中,单CPU通过veSAL全力调用后端加速器,即可实现最高约20GB/s的压缩吞吐,相比纯软件方案提升30-50倍。在Deflate等高压缩比算法上,硬件加速带来的性能提升更为明显,同时时延表现也非常优秀。

火山存储veSAL实战:大量节省CPU资源,显著提升性能

在火山存储的一个时延敏感业务场景中,系统需要从网络端持续拉取16K至32K的大数据块。对于这种大数据块,如果直接用CPU驱动软件压缩,速度太慢,时延不达标,无法满足业务要求。

于是,聪明的工程师想到了办法:把16K数据块拆成4个4K文件,用4个CPU核4个线程并行做压缩和CRC,最后满足了时延上的要求。这种靠拆数据加上堆CPU核数的做法是第一阶段的方式。

第二阶段中,工程师开始引入veSAL,但处理逻辑没有变化,仍然是把它拆成4个4K数据块,然后对veSAL发4次请求。不同的是,这次实际干活儿的不是CPU核心,而是QAT,这样就省下了4个CPU核。

第三个阶段中,在用veSAL的同时,不再拆16K数据块,而是一次性把16K数据交给QAT。上文也提到,硬件做压缩时,即使数据块变大也不会显著增加延时。这一阶段不仅满足延时要求,省下了CPU核心,处理逻辑得到简化,而且压缩效果也更好。

另外一个案例显示,在高性能网络传输场景中,火山存储用零拷贝(Zero-Copy)技术来减少了数据搬运的开销,但零拷贝技术的数据在内存中呈现高度碎片化状态。这一特性给后续的数据校验(CRC)带来了挑战。

在原有的业务逻辑中,面对碎片化的网络数据包,CPU需要对每一个细碎的数据片段单独计算CRC,最后再将这些结果合并。如果改成先拼接,在计算CRC的话是无法满足时延要求的。所以,整个过程中,CPU必须要参与大量的计算工作。

当接入veSAL后,火山存储利用英特尔DSA硬件加速器的数据搬运与计算能力,重构了处理流程。它将所有零散的数据片段一次性发给后端DSA硬件加速器,在这里完成内存拷贝与拼接,同时并行完成CRC校验的计算。

如此一来,通过把负载卸载到专用加速器,整个过程中CPU不再插手数据的搬运与计算,于是,该业务场景下的CPU使用率从原本的7.2%骤降至0.47%。大幅节省算力的同时,也解决了时延的挑战,资源效率与服务质量双双得到优化。

结束语

可以看到,AI的成本问题,不只是模型或算法的问题,而是系统工程的问题。veSAL将压缩、加解密、CRC等操作从CPU核心卸载到英特尔至强硬件加速器上,帮助火山存储大幅提升了资源利用效率。

对于需要承载海量Token生成的云厂商而言,这种软硬协同的优化,正在成为降低Token成本、支撑AI产品规模化普及的关键。随着AI应用持续向更多场景渗透,可以预见,类似veSAL这样的工程实践还会不断出现。