导读

在大模型技术蓬勃发展的当下,DeepSeek的出现宛如一阵春风,吹散了企业应用大模型的诸多障碍。它凭借创新的算法架构,如在Transformer架构的MoE和注意力机制方面的创新,以及改进的强化学习算法GRPO,大幅提升了模型性能,拉低了大模型的入局门槛,让众多中小客户得以涉足这片曾经遥不可及的领域。通过单机部署的解决方案,企业能够以较低的成本和更简单的部署方式使用大模型,为各行业的智能化转型带来了新的曙光。

然而,现实并非一片坦途。多数企业在享受大模型带来的机遇时,却因缺乏专业的技术团队和丰富的部署经验而陷入困境。他们渴望获得“开箱即用”的解决方案,以减少部署时间和技术门槛,快速实现大模型在业务中的应用。但市场上的部署方案良莠不齐,在服务稳定性、准确率、推理速度等关键维度上差异巨大。一些部署方案在面对高并发请求时,服务容易崩溃;在处理专业问题时,回答准确率低下;推理速度缓慢,无法满足实时性需求,这些问题严重制约了大模型在企业中的实际应用效果。

单机部署低门槛 性能满血释放

元脑R1推理服务器正是为解决这些痛点而生。它在硬件和技术架构上进行了精心设计,以强大的实力满足企业的多样化需求。

硬件架构方面

元脑R1推理服务器的不同型号各有千秋。NF5688G7作为领先的高算效AI计算平台,具备多项卓越的硬件配置。其原生搭载FP8计算引擎,这一设计专门针对DeepSeek R1 671B模型进行优化,使得部署速度快且无精度损失。

显存方面

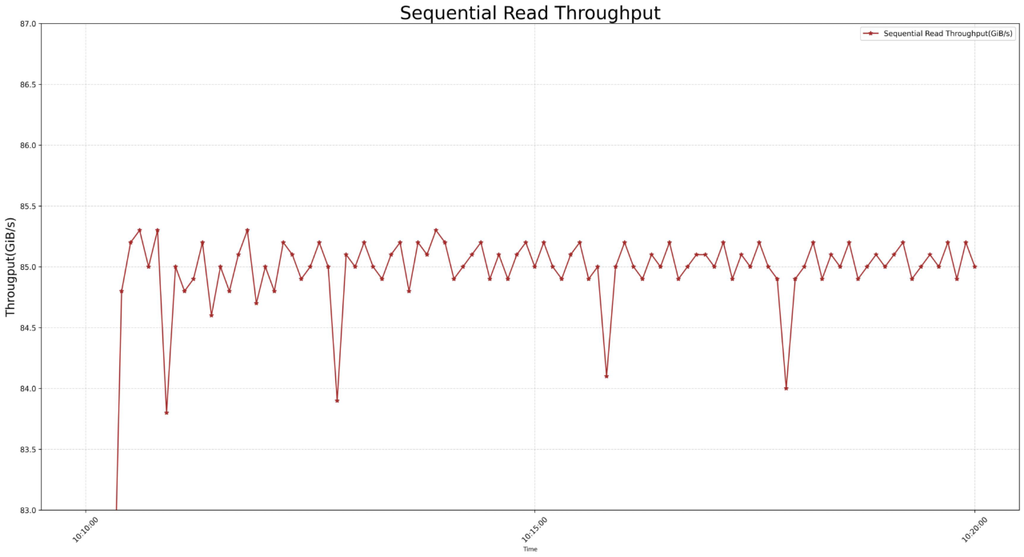

它配备1128GB HBM3e高速显存,这种高速显存能够满足671B模型在FP8精度下不低于800GB显存容量的需求。即使在单机支持全量模型推理的情况下,仍能保留充足的KV缓存空间,为模型推理提供了坚实的基础保障。其显存带宽高达4.8TB/s,如此高的带宽完美契合DeepSeek R1模型“短输入长输出、显存带宽敏感”的技术特征,在推理解码阶段可实现极致加速。

通信方面

GPU P2P带宽达900GB/s,保障了单机部署张量并行时的最佳通讯性能。同时,单台NF5688G7配备3200Gbps无损扩展网络,这一网络配置可根据用户业务需求增长实现敏捷扩展,并且能提供成熟的R1服务器集群Turnkey解决方案,为企业未来的业务拓展提供了便利。

NF5868G8则是专为大推理模型创新设计的高吞吐推理服务器。它在硬件架构上实现了重大突破,业界首次实现单机支持16张标准PCIe双宽卡,提供高达1536GB显存容量,这使得它能够支持在FP16/BF16精度下单机部署DeepSeek 671B模型。其创新研发的基于PCIe Fabric的16卡全互连拓扑更是一大亮点,任意两卡P2P通信带宽可达128GB/s,这种设计极大地降低了通信延迟,相比传统方式降低超60%。通过这样的硬件架构优化,NF5868G8相较传统2机8卡PCIe机型,可将DeepSeek 671B模型推理性能提升近40%。目前该型号已支持多元AI加速卡选配,企业可根据自身业务需求灵活选择,进一步提升服务器的性能和适用性。

软件技术架构层面

元脑R1推理服务器深度优化开源推理框架SGLang。通过对SGLang的优化,服务器实现了更高效的任务调度和资源分配。在处理高并发请求时,优化后的框架能够智能地将任务分配到最合适的计算资源上,充分利用服务器的硬件性能,从而实现单台NF5688G7达到1000路用户并发的出色表现,满足高吞吐场景需求,保障对外服务的效率与稳定性。

通过极限状态下的实测数据,可以反映出机器的性能高低。在实际使用中,比如想要达到同样的使用流畅程度,元脑R1服务器可支持64并发,其他机器只能支持32并发甚至更少,因此需要采购更多的机器,元脑R1服务器大幅降低了客户部署的成本和运维的难度。

实际测试中

其在请求吞吐量、输入输出令牌吞吐量等关键指标上表现优异,为企业提供了高效、稳定的推理服务保障。无论是面对大规模的在线问答场景,还是实时数据分析任务,元脑R1推理服务器都能应对自如,确保企业的业务能够高效运转。

据测算,如果要建设自己的小型智算中心,1~20台元脑R1服务器的区间,会是企业部署私有化算力比较适合的规模,20台机器大概可满足上万人规模大型公司全员流畅的应用体验。

元脑R1推理服务器在单机部署低门槛和降本增效方面表现卓越。基于上述优秀的技术架构,企业无需投入大量资金构建复杂的集群系统,仅需一台元脑R1推理服务器,就能轻松实现DeepSeek R1 671B模型的部署,大幅降低了硬件采购成本与运维难度,为企业提供了最佳的资源规划。

双管齐下 大模型应用开发如虎添翼

与此同时,浪潮信息的元脑企智EPAI企业大模型开发平台与元脑R1推理服务器相得益彰。元脑企智EPAI已全面接入支持DeepSeek大模型,为企业用户提供了强大的开发助力。

回答准确率优化方面

元脑企智EPAI构建了从模型微调到应用开发全链路质量提升体系。支持企业将私有业务数据与DeepSeek深度结合,通过领域微调形成高专业度的私有模型,从根本上提升知识问答精度。针对DeepSeek的“幻觉”问题,集成知识检索、插件管理、提示词工程和智能体编排四大核心工具。实测数据显示,利用DeepSeek在元脑企智EPAI上开发的企业应用回答准确率达到95%,为企业打造高准确率的智能应用提供了坚实支撑。

在开发效率方面

元脑企智EPAI构建了“低代码与可视化”的全栈开发环境。集成vLLM、transformer等主流框架,实现DeepSeek全参数模型服务分钟级上线。某制造企业实践表明,使用元脑企智EPAI开发质检智能体应用,需求响应周期从传统编码开发的3周缩短至3天,开发效率提升5倍以上,大大加速了企业大模型应用的开发进程。

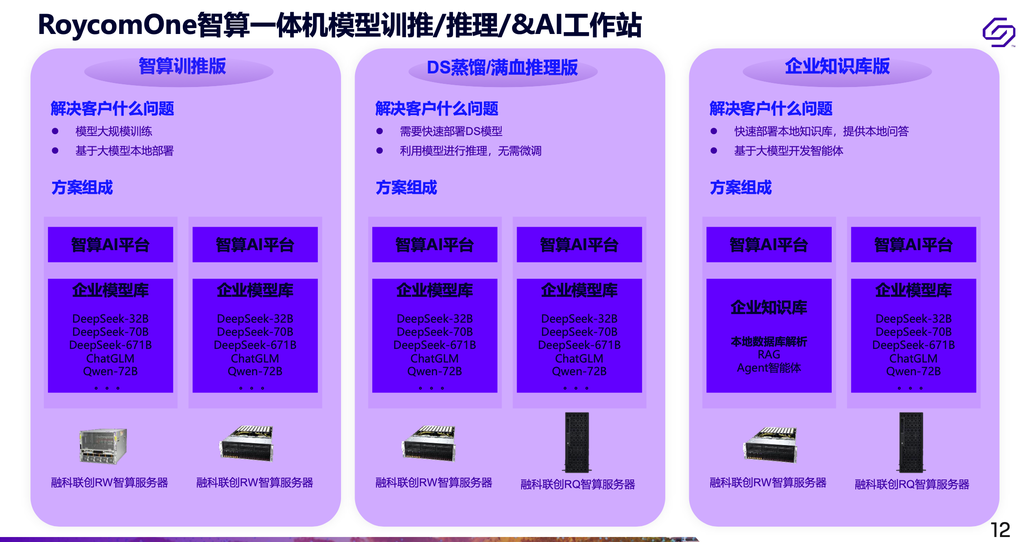

DeepSeek带来算力产业新格局

展望未来,DeepSeek对算力产业和服务器市场将产生深远影响。在算力产业格局方面,它推动了算力需求下沉,使得算力需求从传统的大型企业、互联网公司和央企向更广泛的中小企业和非技术密集型行业扩散,算力市场的整体规模将进一步扩大。同时,硬件需求也发生了变化,单机算力需求增加,算力基础设施需要更多地采用多元算力的形式,将不同类型的芯片(如GPU、FPGA、ASIC)结合在一起,以满足多样化的推理需求。软件平台也在不断优化,企业用户希望将业务数据与大模型深度结合,构建专属智能应用,这促使软件平台不断提升适配性和功能性。

在服务器市场,推理需求呈现爆发式增长,中小客户更倾向于通过一体机或单机部署的方式快速实现推理能力,推理算力市场规模将逐步增大。而训练需求增速虽有所放缓,但仍在增长,不过主要集中在技术能力强的大型企业,这些企业通常自建数据中心或使用云服务,且模型开发逐渐趋于成熟,更多资源开始转向实际应用落地。

元脑R1推理服务器凭借其精心设计的技术架构、在单机部署和性能优化方面的优势,以及与元脑企智EPAI平台的协同效应,在这场大模型应用的浪潮中脱颖而出。它不仅解决了企业当前面临的部署难题,还为企业在未来的智能化发展道路上提供了坚实的技术支撑。随着技术的不断进步和应用的深入推广,相信元脑R1推理服务器将在更多行业发挥重要作用,加速千行百业的智能化转型进程,为大模型技术的广泛应用书写新的篇章。