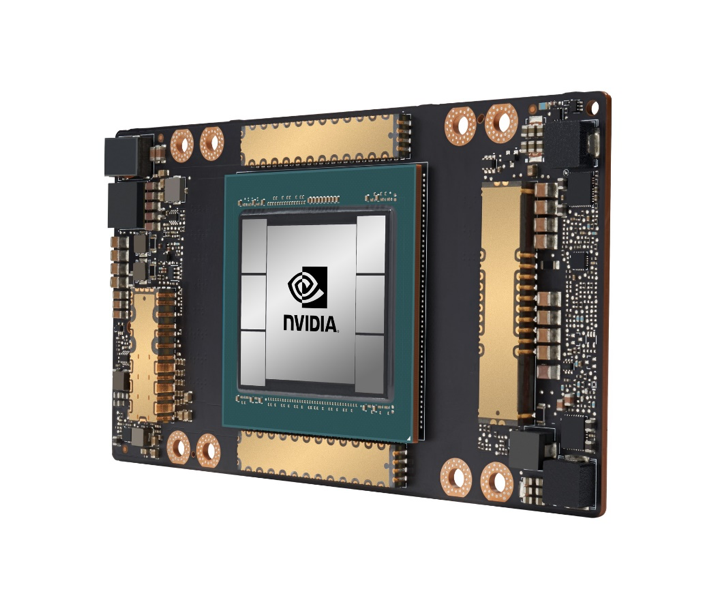

2020年5月14日:NVIDIA宣布首款基于NVIDIA Ampere(安培)架构的GPU —— NVIDIA A100已全面投产并已向全球客户交付。

A100采用了NVIDIA Ampere集AI训练和推理于一身,并且其性能相比于前代产品提升了高达20倍。 作为一款通用型工作负载加速器,A100还被设计用于数据分析、科学计算和云图形。

A100所采用的全新弹性计算技术能够为每项工作分配适量的计算能力。多实例GPU技术可将每个A100 GPU分割为多达七个独立实例来执行推理任务,而第三代NVIDIA NVLink互联技术能够将多个A100 GPU合并成一个巨大的GPU来执行更大规模的训练任务。

A100的五大突破

NVIDIA A100 GPU的突破性技术设计来源于五大关键性创新

1,NVIDIA Ampere架构 – A100的核心是NVIDIA Ampere GPU架构,该架构包含超过540亿个晶体管,这使其成为全球最大的7纳米处理器。

2,具有TF32的第三代Tensor Core核心 – NVIDIA广泛采用的Tensor Core核心现在已变得更加灵活、快速且易于使用。其功能经过扩展后加入了专为AI开发的全新TF32,它能在无需更改任何代码的情况下,使FP32精度下的AI性能提高多达20倍。此外,Tensor Core核心现在支持FP64精度,相比于前代,其为HPC应用所提供的计算力比之前提高了多达2.5倍。

3,多实例GPU – MIG,一种全新技术功能,可将单个A100 GPU分割为多达七个独立的GPU,为不同规模的工作提供不同的计算力,以此实现最佳利用率和投资回报率的最大化。

4,第三代NVIDIA NVLink – 使GPU之间的高速联接增加至原来的两倍,实现服务器的高效性能扩展。

5,结构化稀疏 – 这种全新效率技术利用AI数学固有的稀疏性,使性能提升了一倍。

新系统已搭载NVIDIA A100,很快将登陆云端

同时发布的还有NVIDIA DGX A100 系统,其内置8个由NVIDIA NVLink互联的NVIDIA A100 GPU。NVIDIA和官方合作伙伴现已开始供应该系统。

为帮助合作伙伴加快服务器的开发,NVIDIA开发了HGX A100服务器构建模块,该模块采用了多GPU配置的集成基板形式。

HGX A100 4-GPU通过NVLink实现GPU之间的完整互联, 8-GPU配置的HGX A100通过NVIDIA NVSwitch™实现GPU之间的全带宽通信。采用全新MIG 技术的HGX A100能够被分割为56个小型GPU,每个GPU的速度都比NVIDIA T4更快;或者也可以将其用作一台拥有10petaflops AI性能的巨型8-GPU服务器。

阿里云、AWS、百度智能云、Google Cloud、Microsoft Azure 、甲骨文和腾讯云正在计划提供基于A100的服务。此外,众多全球领先的系统制造商也将提供各种基于A100的服务器。