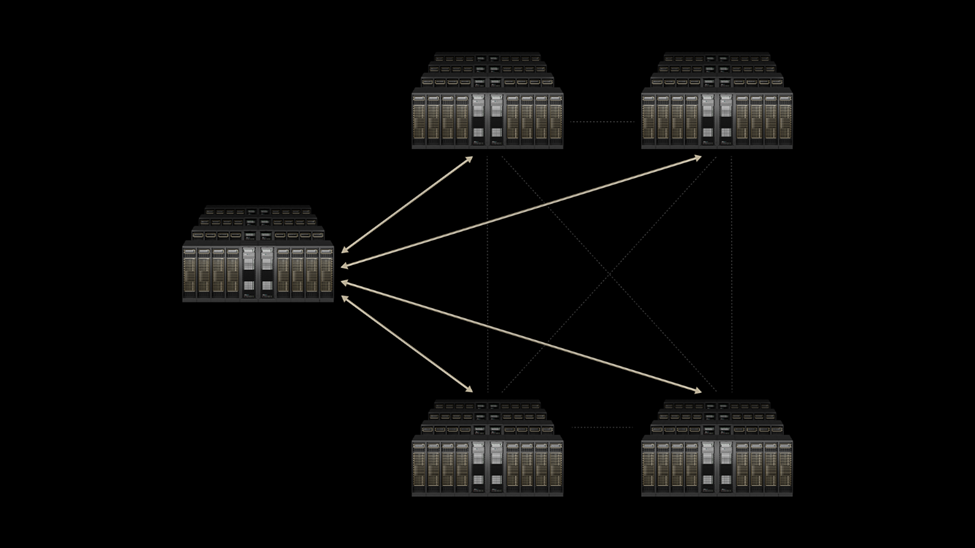

在Hot Chips 2025大会上,NVIDIA正式推出Spectrum-XGS以太网技术——这一“跨区域扩展”(Scale-Across)技术可将地理上分散的多个数据中心整合为统一的十亿瓦级AI超级工厂,彻底打破单个数据中心在电力、容量上的物理限制,为AI工业化浪潮提供关键基础设施支撑。首批采用该技术的企业包括Hyperscale领域的先锋CoreWeave,其将率先通过Spectrum-XGS连接旗下数据中心,为全球用户提供万亿级参数AI模型的高效运行能力。

AI爆发催生“超级工厂”需求,传统网络成瓶颈

随着生成式AI、大语言模型(LLM)参数规模突破万亿,AI计算需求正呈指数级增长。传统单个数据中心已逼近电力(如单设施功耗上限)与容量(如GPU集群规模)的双重天花板——据NVIDIA数据,现代AI工厂需协调数万台甚至数十万台GPU协同工作,而传统以太网基础设施存在高延迟、信号抖动、性能不可预测等问题,无法满足分布式AI训练与推理的严苛需求。

“AI工业革命已然到来,巨型AI工厂是这场革命的核心基础设施。”NVIDIA创始人兼CEO黄仁勋表示,“借助Spectrum-XGS以太网技术,我们在‘纵向扩展’(Scale-Up)和‘横向扩展’(Scale-Out)能力之外,新增了‘跨域扩展’维度,可将分布在城市、国家乃至全球的数-据中心连接成庞大的千兆级AI超级工厂。”

这种需求背后,是AI工作负载的根本性变化:训练万亿参数模型需将计算任务拆分到数万GPU节点,通过“全归约”(All-Reduce)、“全交换”(All-to-All)等集合操作实时合并数据;而推理阶段的检索增强生成(RAG)、多租户云服务,则要求网络兼具低延迟、高吞吐量与用户间性能隔离。传统以太网为单服务器 workload 设计,面对此类需求时吞吐量仅能达到60%左右(因流冲突),成为AI规模化的关键瓶颈。

Spectrum-XGS如何打通“跨区域”壁垒?

作为NVIDIA Spectrum-X以太网平台的突破性升级,Spectrum-XGS并非孤立技术,而是通过“软件算法与硬件整合”构建的跨区域AI网络解决方案。

Spectrum-XGS深度整合于Spectrum-X平台,搭载距离自适应拥塞控制算法与端到端遥测技术,可根据数据中心间的物理距离(如跨城市、跨区域)实时调整网络参数。

依托Spectrum-X平台的硬件基础,Spectrum-XGS延续了“无损网络与高性能硬件”的设计:搭配NVIDIA Spectrum-X交换机,配合NVIDIA ConnectX-8超级网卡(SuperNIC)。

为支撑千兆级AI工厂的能耗与可靠性需求,Spectrum-XGS与NVIDIA最新的共封装光学(CPO)技术深度协同。不同于传统“交换机ASIC与外置光模块”的设计,CPO将硅光子引擎直接集成到交换机封装内,光纤直接连接ASIC旁的光学引擎。

全栈技术支撑“超级工厂”运转

Spectrum-XGS的价值并非孤立存在,而是与NVIDIA的AI全栈技术形成协同,构建“纵向扩展-横向扩展-跨区域扩展”的三层AI基础设施架构:

纵向扩展(Scale-Up):依托NVLink Fusion技术,单个机架内的GPU可通过NVLink Switch实现全连接——例如GB200 NVL72系统将36个GB200超级芯片(含72个Blackwell GPU)连接成单一NVLink域,提供130 TB/s的GPU间带宽,使整个机架成为“一台巨型GPU”;

横向扩展(Scale-Out):通过NVIDIA Quantum InfiniBand交换机(如Quantum-X800)连接多个机架,利用SHARPv4技术在网络内完成集合操作,支撑数十万GPU的集群调度;

跨区域扩展(Scale-Across):由Spectrum-XGS打通地理壁垒,将上述集群整合为跨数据中心的AI超级工厂,同时兼容企业已有的以太网软件生态(如Cumulus Linux、开源SONiC操作系统),降低迁移成本。

此外,NVIDIA的开源软件生态进一步优化Spectrum-XGS的性能:NCCL库实现跨区域GPU间的高效通信,TensorRT-LLM针对Blackwell架构优化推理kernels,Dynamo框架通过“解耦推理阶段与LLM感知调度”提升跨区域推理吞吐量(如GPT-OSS 120B模型交互速度提升4倍)。这种“硬件-软件-算法”的深度整合,确保跨区域AI集群不仅“连得通”,更能“跑得顺”。

CoreWeave率先部署,加速行业应用

作为首批采用Spectrum-XGS的企业,云计算服务商CoreWeave计划将其数据中心网络升级为“统一AI超级计算机”。“CoreWeave的使命是为全球创新者提供最强大的AI基础设施,”

CoreWeave联合创始人兼CTO Peter Salanki表示,“借助Spectrum-XGS,我们可将分布在不同地区的数据中心整合成单一计算单元,让客户获得千兆级AI算力,加速各行业的突破性创新——从药物研发到自动驾驶仿真。”

除CoreWeave外,NVIDIA已与Cisco、Dell Technologies、HPE、Supermicro等合作伙伴达成合作,计划将Spectrum-XGS集成到其服务器与数据中心解决方案中,推动跨区域AI超级工厂的规模化落地。

开启十亿瓦AI工厂时代

Spectrum-XGS的发布,标志着AI基础设施正式进入“十亿瓦级”阶段——据NVIDIA预测,未来几年将出现搭载百万GPU、功耗达十亿瓦的AI工厂,支撑物理AI(如机器人、自动驾驶)、个性化医疗、国家级语言服务等场景。而Spectrum-XGS通过“跨区域扩展”能力,使这类超大规模设施无需局限于单一物理地点,可根据电力、算力需求灵活分布,同时保持高效协同。

从NVLink缝合机架内GPU,到Quantum InfiniBand连接集群,再到Spectrum-XGS打通跨区域壁垒,NVIDIA正通过全栈创新重新定义“数据中心即计算机”——在这场AI工业化革命中,网络不再是“后端组件”,而是驱动创新的核心支柱。